[ad_1]

- La marca Challenger Ugreen dice que su último NAS insignia tiene un LLM integrado

- Está equipado con Intel Core Ultra 5 y admite hasta ocho unidades.

- Me gusta el hecho de que tiene LAN dual GbE e incluso un puerto OCuLink

motor 8 gente ¿Con el modelo integrado de lenguaje grande (LLM)? Cuenta conmigo.

Salón de electrónica de consumo 2025 Hemos visto una gran cantidad de anuncios de hardware interesantes a lo largo de la semana, pero los nuevos modelos UGREEN NASync iDX6011 e iDX6011 Pro se encuentran sin duda entre los mejores y más brillantes.

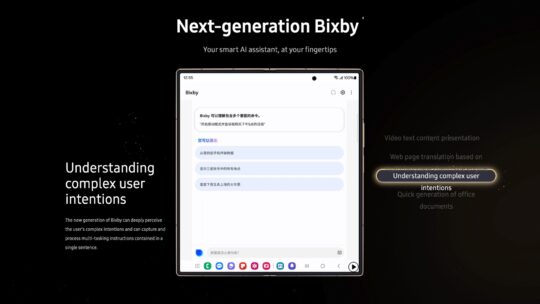

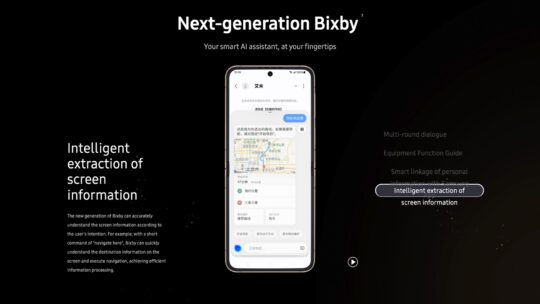

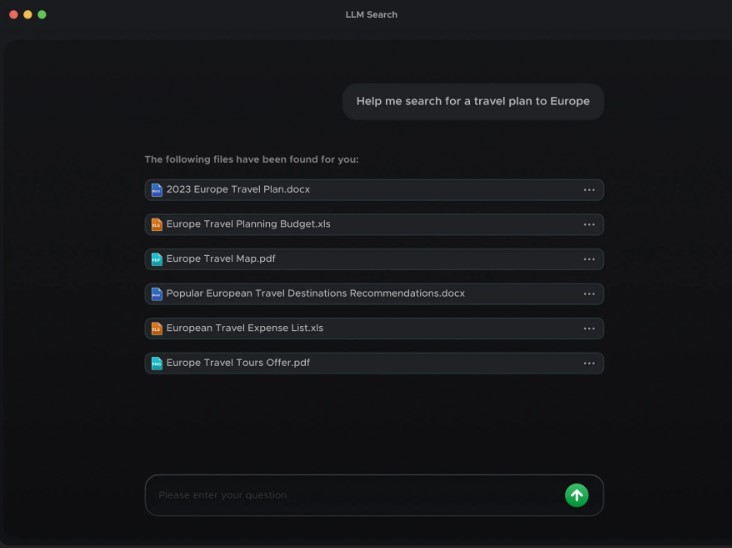

Beneficio Inteligencia artificial generativalos usuarios pueden interactuar con los dispositivos NAS en lenguaje natural, lo que les permite hacer preguntas relacionadas con información de bases de datos o incluso resumir documentos y automatizar tareas.

Debajo del capó está la serie NASync iDX6011

Aunque en este momento no somos ajenos a las capacidades de IA generativa y las indicaciones del lenguaje natural, esto representa un cambio gradual en la forma en que los usuarios interactúan con ellos. Almacenamiento conectado a la red Dispositivos.

Los beneficios de productividad por sí solos aquí son impresionantes. Al incorporar capacidades de inteligencia artificial, Ugreen tiene la capacidad de reducir significativamente el estrés de las tareas manuales y optimizar el flujo de trabajo diario al eliminar la necesidad de que los usuarios busquen información o conjuntos de datos importantes.

Ugreen desea enfatizar que esta nueva serie marca el lanzamiento del “primer NAS impulsado por IA” del mundo con certificaciones LLM integradas: así es como se comparan.

La serie NASync iDX6011 aprovecha el apalancamiento Procesadores Intel Core Ultra 5 Con un chip de 14 núcleos y 18 hilos capaz de alcanzar velocidades de hasta 4,5 GHz, lo que la convierte en una línea potente desde el principio y capaz de manejar tareas intensivas. Amnistía Internacional Cargas de trabajo.

Cabe señalar que NASync iDX6011 está equipado con Intel Procesador Core Ultra 5 125H. Sin embargo, el 6011 Pro cuenta con el último procesador Intel Core Ultra, según Ugreen.

La capacidad de almacenamiento es, por supuesto, otro punto clave de la serie iDX.

Análisis de nascomaris Antes del CES, noté que los dispositivos se destacan en este sentido, con una capacidad de almacenamiento total de 160 TB, respaldada por seis ranuras SATA y dos ranuras M.2 NVMe.

Esto lo hace ideal para usuarios que manejan grandes conjuntos de datos o bibliotecas multimedia.

En otros lugares, los dispositivos NAS también cuentan con puertos de red duales de 10 Gb3, lo que ayuda a mejorar el rendimiento y puede ofrecer velocidades de transferencia de datos de hasta 2500 MB/s.

Un gran atractivo para los usuarios aquí será el hecho de que ofrece capacidades de redundancia para garantizar que el acceso y las transferencias de datos no se interrumpan en caso de una falla en la conexión.

La serie IDX también aprovecha la nube personal de Ugreen Sistema operativo, Yugos Proproporcionando a los usuarios una interfaz segura y fácil de usar.

El NASync iDX6011 Pro lleva las cosas a un nivel superior

Para los usuarios que buscan algo más potente, el iDX6011 Pro es la elección perfecta en este caso.

Esto viene completo con OCuEnlace puerto, proporcionando a los usuarios conectividad de alta velocidad y capacidades de transferencia de datos.

integración iluminación El peering significa que los usuarios pueden conectarse directamente entre el NAS y los dispositivos de almacenamiento externos con menor latencia y mayor rendimiento.

Finalmente, esto proporciona a los usuarios una capacidad de ancho de banda de hasta 64 Gbps. Esto también ofrece una gama más amplia de accesorios compatibles en comparación con el iDX6011 básico, como SSD externos o posibles aceleradores.

También te puede gustar

[ad_2]

Source Article Link