[ad_1]

En un movimiento estratégico que podría remodelar el panorama de la realidad mixta, Google y Samsung anunciaron una asociación el jueves para desarrollar un nuevo visor de realidad mixta que se ejecuta en el sistema operativo Android XR, según un nuevo informe. Claramente, los auriculares Android XR de Google y Samsung desafían directamente a los auriculares Vision Pro y Meta de Apple en el mercado premium.

La colaboración tiene como objetivo crear un ecosistema más accesible y diverso para dispositivos de realidad extendida (XR), que podría ofrecer a los compradores, incluidos los usuarios de Apple, opciones alternativas en el creciente espacio de la realidad mixta. Por supuesto, una mayor competencia puede afectar las características y los precios.

Los auriculares Android XR de Google y Samsung competirán con los Vision Pro

Samsung Los próximos auriculares tienen el nombre en código Proyecto Moohan (en coreano significa “infinito”), se ejecutará en una versión de Android diseñada específicamente para dispositivos XR. Bloomberg Mencioné. El nuevo sistema operativo representa el ambicioso intento de Google de repetir su éxito en el campo de los teléfonos inteligentes, ya que el sistema Android ejecuta la mayoría de los dispositivos móviles del mundo. Pero la gente se dio cuenta Muy similar a VisionOS.

Aunque Vision Pro de Apple ha establecido nuevos estándares en tecnología de realidad mixta, todavía plantea un gran desafío. Precio $3,499 y mencioné Problemas de peso Ha limitado su adopción generalizada. La asociación entre Google y Samsung parece estar estratégicamente posicionada para abordar estas limitaciones, aunque aún no hay información sobre el precio real de los auriculares. Pero probablemente ofrecerá opciones más accesibles para los consumidores interesados en experiencias de realidad mixta.

Mercado en rápido crecimiento

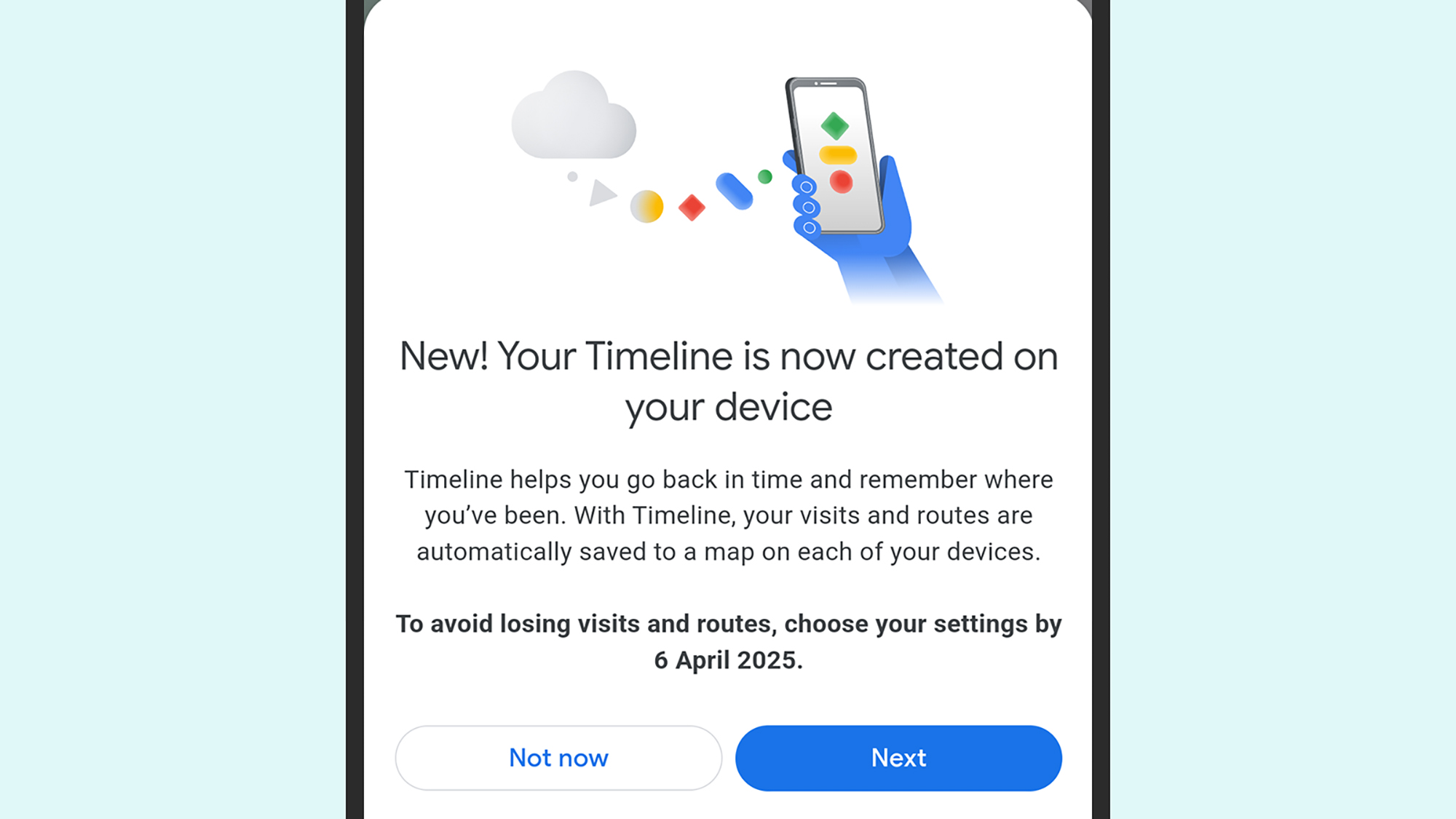

El nuevo sistema operativo Android XR tendrá inteligencia artificial en su núcleo. Si ofrece aplicaciones prácticas que puedan atraer a los usuarios de Apple acostumbrados a una integración tecnológica perfecta, Bloomberg Dijo. Por ejemplo, el sistema podría utilizar cámaras externas para proporcionar instrucciones de montaje de muebles en tiempo real o permitir una planificación integral de vacaciones a través de Google Maps, demostrando casos de uso práctico que van más allá de las aplicaciones tradicionales de realidad virtual.

Este desarrollo representa un cambio importante en el mercado de la realidad mixta. Los grandes actores tecnológicos ya se han comprometido con la plataforma. Sony Group Corp y Xreal Inc. anunciados y Lynx Mixed Reality han anunciado planes para desarrollar dispositivos utilizando el nuevo sistema operativo Android XR, lo que sugiere que puede surgir un ecosistema robusto para competir con el enfoque más controlado de Apple.

Las soluciones se dirigen a diferentes dispositivos

NUEVO: Práctica con los primeros auriculares de realidad mixta de Samsung y Google y Android XR. Estoy impresionado. Este auricular muestra que el hardware Vision Pro debe evolucionar rápidamente. Y Meta pronto tendrá un competidor en gafas. https://t.co/HpIZoGS9RT

–Mark Gurman (@markgurman) 12 de diciembre de 2024

Samir Samat, jefe del ecosistema Android de Google, destacó que la plataforma está diseñada para soportar un grupo de dispositivos que resuelven diferentes problemas, lo que contradice la estrategia de un solo dispositivo de Apple. Este enfoque podría conducir a auriculares especializados para juegos, entretenimiento, procedimientos médicos y deportes profesionales. Esto podría proporcionar a los usuarios de Apple soluciones más específicas para necesidades específicas.

El momento del anuncio es importante, ya que el mercado de la realidad mixta sigue evolucionando. Si bien Apple ha puesto el listón alto en lo que respecta a las capacidades de Vision Pro, la asociación entre Google y Samsung muestra que la competencia en el espacio de los auriculares premium se intensificará en 2025.

Auriculares Android XR de Google y Samsung: La competencia puede beneficiar a los consumidores

Los próximos auriculares Android XR de Google y Samsung podrían representar un punto de decisión interesante para los usuarios de Apple. Si bien Vision Pro ofrece una integración perfecta con el ecosistema de Apple, el próximo Android XR promete una gama más diversa de dispositivos y precios potencialmente más accesibles. Si esta nueva plataforma tiene éxito, podría impactar en la estrategia futura de Apple en el campo de la realidad mixta. Podría beneficiar a los consumidores a través de una mayor competencia e innovación, sin mencionar precios más bajos.

El lanzamiento de los auriculares Project Moohan de Samsung está previsto para el próximo año. Esto debería allanar el camino para una batalla de mercado convincente. A medida que estas tecnologías sigan madurando, los usuarios de Apple tendrán más opciones a considerar al elegir su punto de entrada al mundo de la realidad mixta.

[ad_2]

Source Article Link