[ad_1]

Acaba de llegar uno de los productos relacionados con la IA más esperados: el generador de vídeo Sora AI de OpenAI Despedido Lunes como parte de la empresa. 12 días de OpenAI Sucedió.

OpenAI ha proporcionado un adelanto de la producción de Sora en el pasado. Pero, ¿qué tan diferente será en el lanzamiento? OpenAI ciertamente ha puesto mucho esfuerzo en actualizar y mejorar su generador de video impulsado por IA en preparación para su lanzamiento público.

El YouTuber Marques Brownlee tuvo un Primer vistazo a Soralanzando su reseña en video de los últimos productos de OpenAI horas antes de que OpenAI anunciara oficialmente el lanzamiento. ¿Qué pensó Brownlee?

¿En qué es bueno Sora?

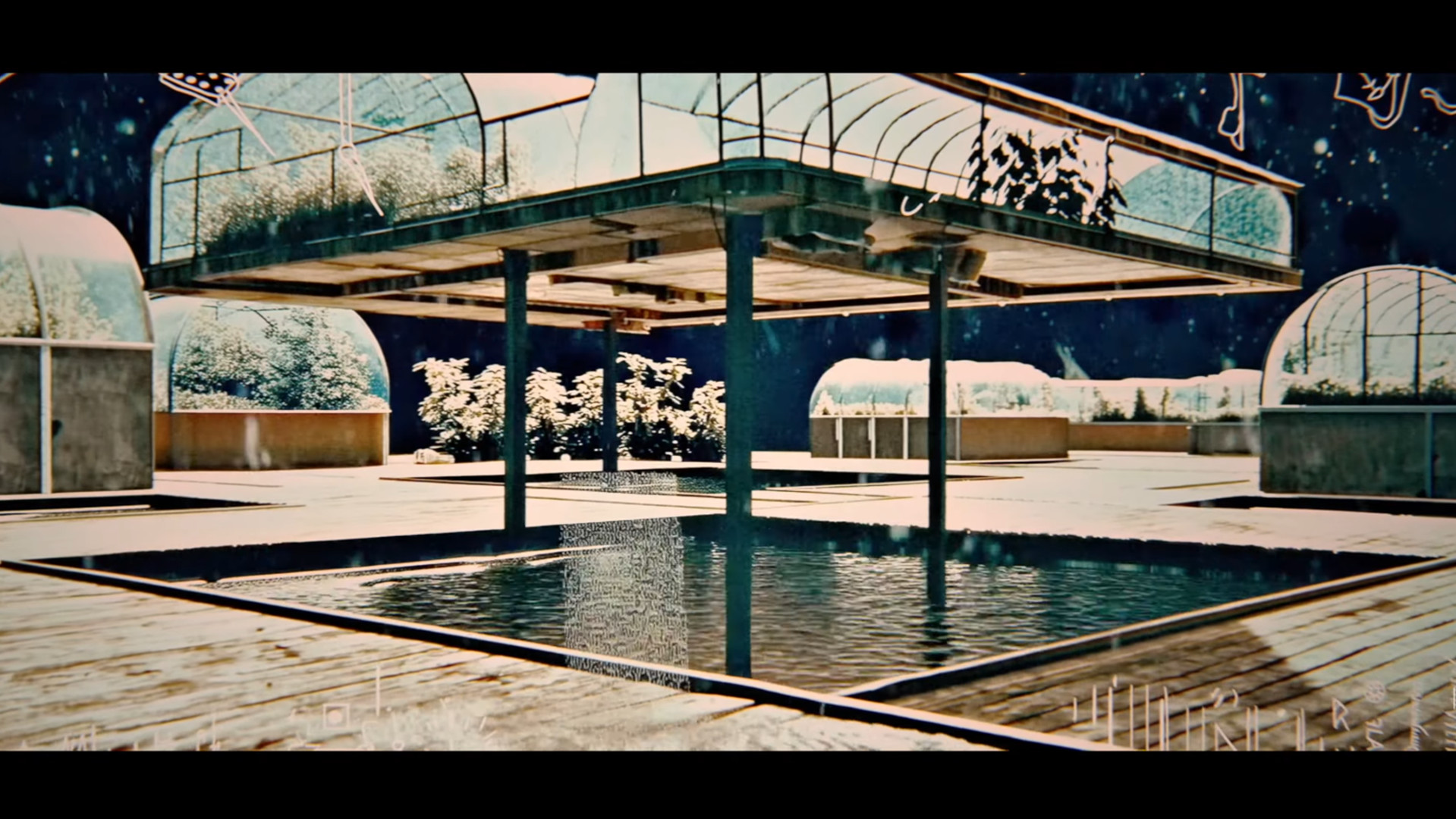

Según Brownlee, sus pruebas de Sora descubrieron que el generador de vídeo con IA destaca en la creación de paisajes. Las tomas de la naturaleza o paisajes famosos generadas por IA parecen imágenes de archivo de la vida real. Por supuesto, como señala Brownlee, si conoce bien cómo se ven los alrededores del monumento, es posible que pueda detectar diferencias. Sin embargo, no hay mucho que parezca claramente generado por IA en este tipo de clips generados por Sora.

Quizás el tipo de vídeo que Sora puede crear mejor, según Brownlee, son los vídeos abstractos. Sora puede crear bien arte abstracto de fondo o protector de pantalla incluso con instrucciones específicas.

Velocidad de la luz triturable

Brownlee también descubrió que ciertos tipos de contenido animado creado por Sora, como la animación stop-motion o la animación tipo Claymation, a veces parecían aceptables, ya que los movimientos a veces entrecortados que todavía plagan el video de IA parecían opciones estilísticas.

Aún más sorprendente, Brownlee descubrió que Sora era capaz de manejar imágenes de texto animadas muy específicas. Las palabras suelen aparecer como texto distorsionado en otros modelos de generación de imágenes y vídeos impulsados por IA. Con Sora, Brownlee descubrió que siempre que el texto fuera específico, como algunas palabras en una tarjeta de título, Sora podía crear la imagen con la ortografía correcta.

Donde Sora sale mal

Sin embargo, Sora todavía presenta muchos de los mismos problemas que afectaron a todos los generadores de video de IA anteriores.

Lo primero que menciona Brownlee es la permanencia del objeto. Sora tiene problemas para mostrar un objeto específico en la mano de alguien, por ejemplo, durante todo el vídeo. A veces el objeto se mueve o desaparece repentinamente. Al igual que con el texto de IA, el vídeo de IA de Sora sufre alucinaciones.

Lo que lleva a Brownlee al mayor problema de Sora: la física en general. El vídeo realista parece ser todo un desafío para Sora porque parece que no puede animar la acción correctamente. Una persona que simplemente camina comenzará a disminuir o acelerar de manera antinatural. A veces, las partes del cuerpo u objetos también se distorsionan repentinamente y se convierten en algo completamente diferente.

Y aunque Brownlee mencionó estas mejoras con el texto, a menos que seas muy específico, Sora todavía distorsiona la ortografía de cualquier tipo de texto de fondo, como el que puedes ver en edificios o señales de tráfico.

Sora es en gran medida un trabajo en progreso y OpenAI también participó durante el lanzamiento. Aunque puede ser un paso adelante en comparación con otros generadores de video con IA, está claro que hay solo unas pocas áreas en las que todos los modelos de video con IA encontrarán desafíos.

[ad_2]

Source Article Link