[ad_1]

Las máquinas crearán superinteligencia, dice Sam Altman de OpenAI, la empresa que desarrolló ChatGPT. Se necesita investigación para verificar estas y otras afirmaciones.Fotografía: Jason Redmond/AFP/Getty

“Es posible que tengamos superinteligencia dentro de unos miles de días (!); “Puede que tome más tiempo, pero estoy seguro de que lo lograremos”.

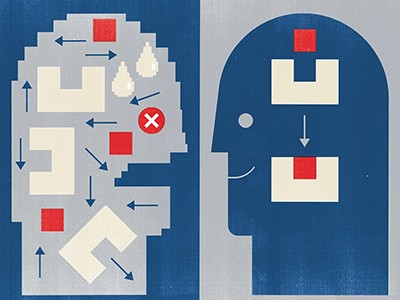

Así escribió Sam Altman, director ejecutivo de OpenAI, una empresa de tecnología con sede en San Francisco, California, el 23 de septiembre. Esto fue menos de dos semanas después de que la compañía detrás de ChatGPT lanzara o1, su modelo de lenguaje grande (LLM) más avanzado hasta la fecha. Una vez confinados al ámbito de la ciencia ficción, la aparición de programas LLM en los últimos años ha renovado la importancia de la cuestión de cuándo podremos crear inteligencia artificial general (AGI). Aunque carece de una definición precisa, la inteligencia artificial general se refiere en términos generales a un sistema de inteligencia artificial capaz de razonar, generalizar, planificar y tener autonomía a nivel humano.

¿Qué tan cerca está la inteligencia artificial de la inteligencia humana?

Los formuladores de políticas de todo el mundo tienen preguntas sobre la inteligencia artificial general, incluidos sus beneficios y riesgos. No es fácil responder a estas preguntas, especialmente porque gran parte del trabajo se realiza en el sector privado, donde los estudios no siempre se publican públicamente. Pero lo que está claro es que las empresas de IA están muy centradas en dotar a sus sistemas de toda la gama de capacidades cognitivas que tenemos los humanos. Las empresas que desarrollan modelos de IA tienen un fuerte incentivo para mantener la idea de que la AGI está a la vuelta de la esquina, para atraer interés y, por tanto, inversión.

Hubo consenso entre los investigadores que hablaron con él. naturaleza Para ver un artículo de noticias publicado esta semana (ver naturaleza 63622-25; 2024) Los modelos de lenguajes grandes (LLM), como o1, Gemini de Google y Claude, fabricados por Anthropic, con sede en San Francisco, aún no han entregado AGI. Basándose en conocimientos de la neurociencia, muchos dicen que hay buenas razones para creer que los LLM nunca lo harán y que la IA necesitará otras tecnologías para lograr una inteligencia a nivel humano.

A pesar de la amplitud de sus capacidades (desde generar código de computadora hasta resumir artículos académicos y responder preguntas de matemáticas), existen limitaciones fundamentales en la forma en que operan los programas de MBA más potentes, que esencialmente implica consumir una gran cantidad de datos y usarlos para predecir “código”. ” próximo. En una serie. Esto genera respuestas plausibles a un problema, en lugar de resolverlo realmente.

Inteligencia artificial y ciencia: lo que piensan 1.600 investigadores

Francois Cholet, ex ingeniero de software de Google, con sede en Mountain View, California, y Subbarao Kambhampati, científico informático de la Universidad Estatal de Arizona en Tempe, probaron el rendimiento del o1 en tareas que requieren pensamiento abstracto y planificación, y descubrieron que funciona bien. menos que el AGI. Si ocurre la inteligencia artificial general, algunos investigadores creen que los sistemas de IA necesitarán “modelos universales” coherentes, o representaciones de su entorno que puedan usar para probar hipótesis, razonar, planificar y generalizar el conocimiento aprendido en un dominio a otras situaciones ilimitadas.

Aquí es donde las ideas de la neurociencia y la ciencia cognitiva pueden impulsar próximos descubrimientos. Por ejemplo, el equipo de Yoshua Bengio de la Universidad de Montreal en Canadá está explorando arquitecturas de IA alternativas que respaldarían mejor la construcción de modelos mundiales coherentes y la capacidad de razonar utilizando dichos modelos.

Algunos investigadores sostienen que los próximos avances en IA tal vez no provengan de sistemas más grandes, sino de una IA más pequeña y con mayor eficiencia energética. Los sistemas más inteligentes del futuro también pueden requerir menos datos para el entrenamiento si tienen la capacidad de decidir qué aspectos de su entorno tomar muestras, en lugar de limitarse a absorber lo que se les alimenta, dice Karl Friston, neurocientífico teórico del University College de Londres.

Este trabajo demuestra que investigadores de diversos campos deben participar en el desarrollo de la inteligencia artificial. Esto será necesario para verificar que los sistemas realmente funcionen, garantizar que estén a la altura de las afirmaciones de las empresas de tecnología e identificar los resultados que requiere el proceso de desarrollo. Sin embargo, actualmente, el acceso a los principales sistemas de IA puede resultar difícil para los investigadores que no trabajan en empresas que puedan permitirse la enorme cantidad de unidades de procesamiento de gráficos (GPU) necesarias para entrenar los sistemas (A. Khandelwal et al. Preimpresión en arXiv https://doi.org/nt67; 2024).

ChatGPT pasó la prueba de Turing y comienza la carrera para encontrar nuevas formas de evaluar la inteligencia artificial

Para dar una idea de la escala de actividad, en 2021, las agencias gubernamentales de EE. UU. (excluido el Departamento de Defensa) asignaron 1.500 millones de dólares a la investigación y el desarrollo de la IA, y la Comisión Europea gasta alrededor de 1.000 millones de euros (1.050 millones de dólares) al año. . Por el contrario, empresas de todo el mundo gastaron más de 340 mil millones de dólares en investigación de IA en 2021 (norte. ahmed et al. ciencias 379884-886; 2023). Hay maneras de hacer esto Los gobiernos pueden financiar la investigación de la IA A mayor escala, por ejemplo mediante la puesta en común de recursos. El Consorcio de Laboratorios de Investigación de Inteligencia Artificial en Europa, una organización sin fines de lucro con sede en La Haya, Países Bajos, ha propuesto construir un “CERN para la IA” que podría atraer el mismo nivel de talento que las empresas de IA y así crear empleos. – Entorno de investigación avanzada.

Es difícil predecir cuándo llegará el AGI, con estimaciones que van desde dentro de unos pocos años hasta una década o más. Pero es seguro que se producirán avances más masivos en IA, y gran parte de ellos probablemente provendrán de la industria, considerando el monto de la inversión. Para garantizar que estos desarrollos sean útiles, las investigaciones realizadas por las empresas de tecnología deben verificarse utilizando la mejor comprensión actual de lo que constituye la inteligencia humana, según la neurociencia, las ciencias cognitivas, las ciencias sociales y otros campos relacionados. Esta investigación financiada con fondos públicos debería desempeñar un papel importante en el desarrollo de la inteligencia artificial general.

La humanidad necesita aprovechar todo el conocimiento para que las aplicaciones de la investigación en IA sean sólidas y sus riesgos se mitiguen al máximo. Los gobiernos, las empresas, los financiadores de la investigación y los investigadores deben reconocer sus fortalezas complementarias. Si no lo hacen, se perderán conocimientos que podrían ayudar a mejorar la IA y los sistemas resultantes podrían volverse impredecibles y, por tanto, inseguros.

[ad_2]

Source Article Link