[ad_1]

Las marcas de agua pronto podrían llegar a un chatbot con tecnología de inteligencia artificial cerca de usted.Fotografía: Jonathan Ra/NoorPhoto/Getty

Pocas veces una herramienta o tecnología ha surgido tan repentinamente del mundo de la investigación para la concientización pública (y se ha utilizado tan ampliamente) como la inteligencia artificial generativa (IA). La capacidad de los grandes modelos lingüísticos (LLM) para crear textos e imágenes que son casi indistinguibles de los creados por humanos está perturbando, si no revolucionando, innumerables áreas de la actividad humana. Sin embargo, el potencial de uso indebido ya es claro, desde el plagio académico hasta la generación masiva de información errónea. El temor es que la IA esté evolucionando demasiado rápido y, sin barreras de seguridad, pronto será demasiado tarde para garantizar la precisión y reducir los daños.1.

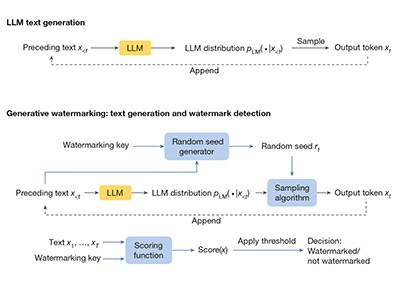

Esta semana, Sumanth Dattathri de DeepMind, el laboratorio de investigación de IA de Google en Londres, y sus colegas anunciaron que habían probado un nuevo enfoque para “marcar de agua” el texto generado por IA al incluir una “firma estadística”, una forma de identificador digital que puede ser. Se utiliza para confirmar el origen del texto.2. La palabra marca de agua proviene de la era del papel y la impresión y describe una diferencia en el grosor del papel, que generalmente no es evidente a simple vista y no altera el texto impreso. Una marca de agua en texto o imágenes creadas digitalmente debe ser invisible para el usuario, pero inmediatamente evidente para el software especializado.

Lea el artículo: Marcas de agua escalables para identificar la salida de modelos de lenguaje grandes

El trabajo de Dhatathri y sus colegas representa un hito importante en la creación de marcas de agua en textos digitales. Pero todavía queda un largo camino por recorrer antes de que las empresas y los reguladores puedan determinar con seguridad si un fragmento de texto es producto de un ser humano o de una máquina. Dado el imperativo de limitar el daño causado por la IA, más investigadores deben intensificar sus esfuerzos para garantizar que la tecnología de marcas de agua esté a la altura de su promesa.

El enfoque de los autores para poner marcas de agua en los resultados del LLM no es nuevo. OpenAI, la empresa con sede en San Francisco, California, detrás de ChatGPT, también está probando una versión. Pero existe poca literatura sobre cómo funciona la tecnología y sus fortalezas y limitaciones. Una de las contribuciones más importantes se produjo en 2022, cuando Scott Aaronson, científico informático de la Universidad de Texas en Austin, describió… Una charla muy comentadaCómo lograr una marca de agua. Otros también han hecho contribuciones valiosas, incluido John Kirchenbauer y sus colegas de la Universidad de Maryland en College Park, quienes publicaron un algoritmo para detectar marcas de agua el año pasado.3.

El equipo de DeepMind ha ido más allá y ha demostrado que las marcas de agua se pueden lograr a escala. Los investigadores integraron una tecnología que llamaron SynthID-Text en el chatbot Gemini de Google, impulsado por inteligencia artificial. En una prueba en vivo de casi 20 millones de usuarios de Gemini que realizaron consultas en el chatbot, las personas no notaron una caída en la calidad de las respuestas con marca de agua en comparación con las respuestas sin marca de agua. Esto es importante porque es menos probable que los usuarios acepten contenido con marca de agua si lo consideran inferior al texto sin marca de agua.

Los modelos de IA alimentados con datos generados por IA rápidamente difunden tonterías

Sin embargo, todavía es relativamente fácil para un diseñador eliminar la marca de agua y hacer que el texto generado por IA parezca escrito por alguien. Esto se debe a que el proceso de marca de agua utilizado en el experimento DeepMind funciona cambiando la forma en que el LLM selecciona estadísticamente sus “tokens”: cómo extrae, ante un mensaje de usuario determinado, del corpus de entrenamiento masivo de miles de millones de palabras de artículos, libros y otras fuentes para compilar una respuesta que parezca razonable. Este cambio puede ser monitoreado por el algoritmo de análisis. Pero hay formas de eliminar la referencia: parafraseando o traduciendo el resultado del LLM, por ejemplo, o pidiendo a otro maestro que lo reescriba. La marca de agua una vez eliminada no es realmente una marca de agua.

Una marca de agua adecuada es importante mientras las autoridades trabajan para regular la IA de una manera que limite el daño que puede causar. La marca de agua se considera una tecnología fundamental. En octubre pasado, el presidente estadounidense Joe Biden dio instrucciones al Instituto Nacional de Estándares y Tecnología (NIST), con sede en Gaithersburg, Maryland, para que estableciera estrictos estándares de pruebas de seguridad para los sistemas de inteligencia artificial antes de su lanzamiento para uso público. El NIST está buscando comentarios públicos sobre sus planes para reducir el riesgo de daño causado por la IA, incluido el uso de marcas de agua, que, según afirma, deberían ser sólidas. Aún no hay una fecha específica sobre cuándo se finalizarán los planes.

¿Cómo piensa ChatGPT? La psicología y la neurociencia abren grandes modelos de lenguaje para la inteligencia artificial

A diferencia de Estados Unidos, la Unión Europea ha adoptado un enfoque legislativo, al aprobar en marzo una ley de IA de la UE y establecer una Oficina de Inteligencia Artificial para hacerla cumplir. El gobierno chino ya ha introducido una marca de agua obligatoria y el estado de California pretende hacer lo mismo.

Sin embargo, incluso si se pueden superar los obstáculos técnicos, una marca de agua sólo será verdaderamente útil si es aceptable para las empresas y los usuarios. Aunque es probable, hasta cierto punto, que la regulación obligue a las empresas a tomar medidas en los próximos años, si los usuarios confiarán en las marcas de agua y tecnologías similares es otra cuestión.

Existe una necesidad urgente de mejorar las capacidades tecnológicas para combatir el uso indebido de la IA generativa y la necesidad de comprender la forma en que las personas interactúan con estas herramientas: cómo los actores maliciosos usan la IA, si los usuarios confían en las marcas de agua y cómo es un entorno de información confiable en el mundo. mundo. El mundo de la inteligencia artificial generativa. Todas estas son preguntas que los investigadores deben estudiar.

En un movimiento bienvenido, DeepMind ha hecho que el modelo y el código subyacente de SynthID-Text sean gratuitos para que cualquiera pueda usarlos. Este trabajo es un importante paso adelante, pero la tecnología en sí está todavía en su infancia. Necesitamos que crezca rápidamente.

[ad_2]

Source Article Link