[ad_1]

Google Presenta un nuevo modelo de inteligencia artificial (IA) de la familia Gemini 2.0. Apodado Gemini 2.0 Experimental Advanced, el modelo de lenguaje grande (LLM) solo estará disponible para suscriptores pagos de Gemini. El lanzamiento del nuevo modelo se produce pocos días después del lanzamiento del gigante tecnológico con sede en Mountain View. Liberado Muestra Gemini 2.0 Flash de la aplicación Gemini para Android. En particular, actualmente solo se puede acceder a la Demostración Avanzada 2.0 a través de la versión web del chatbot con tecnología de inteligencia artificial.

Se está implementando el modelo de demostración avanzado Gemini 2.0

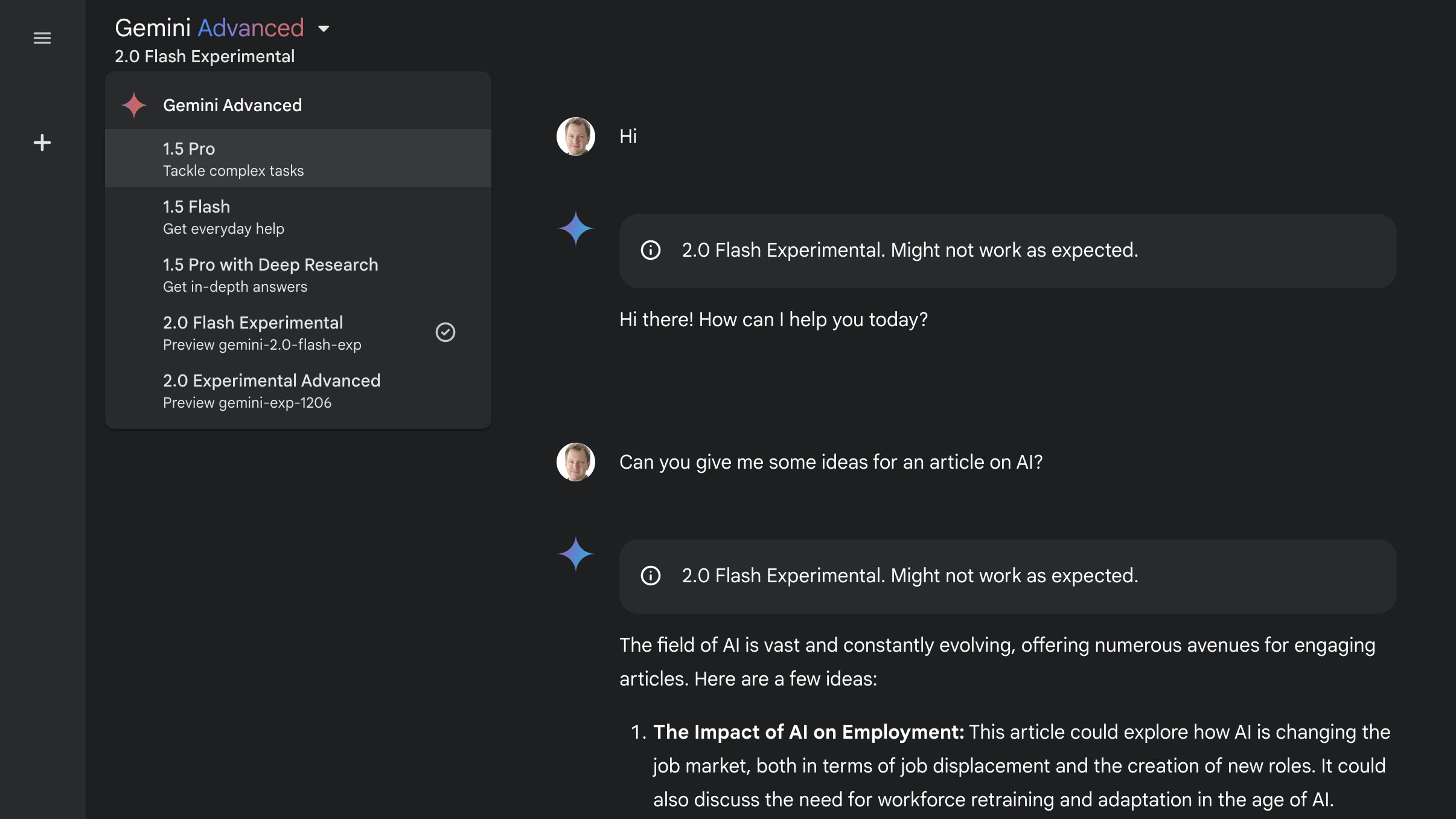

en un Publicación de blogEl gigante tecnológico ha anunciado el lanzamiento de su segundo modelo de IA Gemini 2.0. El nombre en clave oficial del formulario es Gemini-Exp-1206 y se puede seleccionar desde la opción de alternar formulario en la parte superior de la interfaz web del chatbot. Vale la pena señalar que actualmente solo los suscriptores de Gemini Advanced podrán elegir este modelo.

![]()

Nuevo modelo de IA Gemini 2.0

Crédito de la imagen: Google

Aunque Google acaba de anunciar el nuevo modelo de IA, el nombre Gemini-Exp-1206 apareció por primera vez la semana pasada cuando atrás En la tabla de clasificación LLM de Chatbot Arena (anteriormente LMSYS), ocupa el primer lugar con una puntuación de 1374. Actualmente supera a la última versión de los modelos de las series GPT-4o, Gemini 2.0 Flash y o1 de OpenAI.

Disponible sólo en la versión web de mellizoSe dice que el nuevo modelo de IA ofrece importantes mejoras de rendimiento en tareas complejas como programación, matemáticas, razonamiento y seguimiento de instrucciones. Google dijo que puede proporcionar instrucciones detalladas de varios pasos para proyectos de bricolaje, algo con lo que los modelos anteriores tuvieron problemas.

Sin embargo, el gigante tecnológico advierte que el modelo beta 2.0 avanzado está disponible en una versión preliminar y, en ocasiones, es posible que no funcione como se esperaba. Además, el modelo de IA actualmente no tendrá acceso a información en tiempo real y será incompatible con algunas funciones de Gemini. La compañía no mencionó qué funciones no funcionarán con el nuevo LLM.

Vale la pena señalar que Gemini Live es parte de la suscripción Gemini Advanced. Se puede suscribir a través del plan Google One AI Premium que cuesta Rs. 1.950 al mes, después de un mes de prueba gratuita.

[ad_2]

Source Article Link