[ad_1]

Ilustración: Neil Webb

¿Los cirujanos ardilla generan más impacto en las citas? La pregunta parece una tontería, o quizás el comienzo de un mal chiste. Pero la pregunta planteada por el científico de datos Mike Thelwall no fue una broma. Fue una prueba. Thelwall, que trabaja en la Universidad de Sheffield en el Reino Unido, ha estado evaluando la capacidad de los modelos de lenguaje grande (LLM). Evaluar trabajos académicos según estándares. Después de enviar una versión personalizada de ChatGPT a los estándares REF, incorporó 51 de su propio trabajo de investigación al modelo y se sorprendió por la capacidad del chatbot para producir informes razonables. “No hay nada en los informes que indique que no fueron escritos por un experto humano”, afirma. “Este es un logro sorprendente”.

Sin embargo, la hoja de ardilla realmente confundió al modelo. Thelwall creó el artículo tomando uno de sus manuscritos rechazados sobre si los cirujanos varones generan más efectos de citación que las cirujanas y, para hacerlo absurdo, reemplazó “masculino” por “ardilla”, “femenino” por “humano” y cualquier referencia. a género. Lo cambia a “especie” a lo largo del artículo. Su modelo ChatGPT no pudo determinar si los “cirujanos ardilla” no eran reales durante la evaluación, y el chatbot le dio al artículo una puntuación alta.

Índice de la Naturaleza 2024 Inteligencia Artificial

Thelwall también descubrió que el modelo no fue particularmente exitoso en la aplicación de la puntuación basada en las directrices del Marco de Excelencia en Investigación a los 50 artículos evaluados. Concluyó que, aunque el modelo podía producir informes que parecían auténticos, no podía evaluar la calidad.

El rápido aumento de la inteligencia artificial (IA) generativa como ChatGPT y los generadores de imágenes como DALL-E ha aumentado los debates sobre dónde podría encajar la IA en la evaluación de la investigación. Estudiar Thelwall1El estudio publicado en mayo pasado es sólo una pieza del rompecabezas que académicos, instituciones de investigación y financiadores están tratando de armar. El estudio se produce cuando los investigadores también están lidiando con muchas otras formas en que la inteligencia artificial está impactando la ciencia y las pautas en desarrollo que surgen en torno a su uso. Sin embargo, estos debates rara vez se han centrado en brindar orientación sobre cómo se puede utilizar la IA para evaluar la calidad de la investigación. “Esta es la próxima frontera”, afirma Gitanjali Yadav, biólogo estructural del Instituto Nacional Indio de Investigación del Genoma Vegetal en Nueva Delhi y miembro del Grupo de Trabajo de Inteligencia Artificial de la Alianza para el Avance de la Evaluación de la Investigación, una iniciativa global para mejorar prácticas de evaluación de la investigación.

Vale la pena señalar que el auge de la IA también coincide con crecientes llamados a repensar cómo se evalúan los resultados de la investigación. Durante la última década, ha habido llamados a alejarse de las métricas basadas en publicaciones, como los factores de impacto de las revistas y el recuento de citas, que han demostrado ser poco confiables. Vulnerable a la manipulación y al sesgoIncorporar la IA a este proceso en un momento como este brinda la oportunidad de integrarla en nuevos mecanismos para comprender y medir la calidad y el impacto de la investigación. Pero también plantea preguntas importantes sobre si la IA es capaz de ayudar plenamente a evaluar la investigación o si tiene el potencial de exacerbar los problemas e incluso crear más problemas.

Evaluaciones de calidad

Es difícil definir la investigación de calidad, aunque existe un consenso general de que una buena investigación depende de la validez, la precisión, la originalidad y el impacto. Existe una amplia gama de mecanismos, cada uno de los cuales opera en diferentes niveles del ecosistema de investigación, para evaluar estos atributos, y una infinidad de formas de hacerlo. La mayor parte de la evaluación de la calidad de la investigación ocurre en el proceso de revisión por pares, que en muchos casos es la primera revisión de calidad externa realizada sobre una nueva pieza científica. Muchas revistas científicas utilizan el proceso de revisión por pares para evaluar la calidad de la investigación. Un conjunto de herramientas de inteligencia artificial Para completar este proceso durante algún tiempo, existe inteligencia artificial para hacer coincidir los manuscritos con los revisores adecuados, algoritmos que detectan plagio y verifican fallas estadísticas y otras herramientas destinadas a mejorar la integridad mediante la detección de manipulación de datos.

Recientemente, el auge de la IA generativa ha provocado una ola de investigaciones destinadas a explorar hasta qué punto el LLM puede ayudar a la revisión por pares y si los científicos confían en estas herramientas para hacerlo. Algunos editores permiten que la IA ayude en la preparación del manuscrito, si se divulga lo suficiente, pero no permiten su uso en la revisión por pares. Sin embargo, existe una creciente creencia entre los académicos en el poder de estas herramientas, especialmente aquellas basadas en el procesamiento del lenguaje natural y los programas LLM.

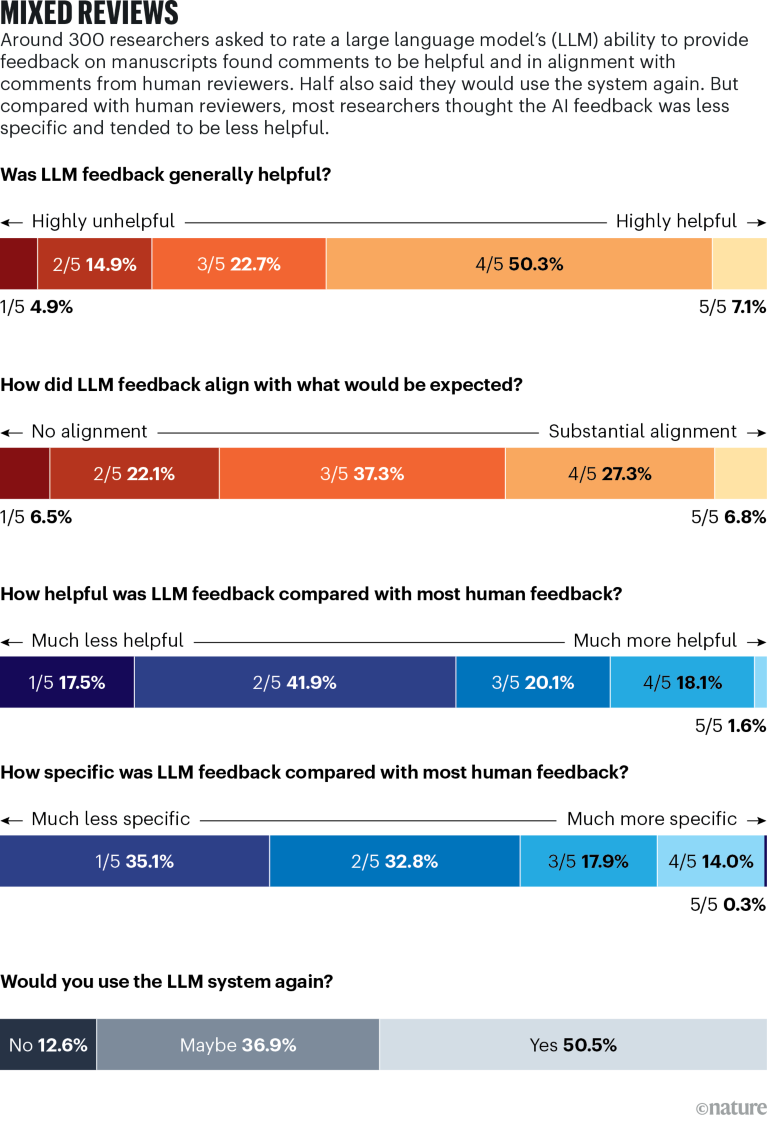

Fuente: Referencia 2

Un estudio publicado en julio de este año2En un estudio realizado por el estudiante de doctorado en informática Weixin Liang en el laboratorio del científico de datos biomédicos James Zhou en la Universidad de Stanford en California, se evaluó la capacidad de un programa LLM, GPT-4, para proporcionar retroalimentación sobre manuscritos. El estudio pidió a los investigadores que cargaran un manuscrito y lo evaluaran mediante su modelo de IA. Luego, los investigadores completaron un cuestionario para evaluar los comentarios y compararlos con los revisores humanos. Recibió 308 respuestas, y más de la mitad describieron las reseñas generadas por IA como “útiles” o “muy útiles”. Pero el estudio destacó algunos problemas con estas observaciones: a veces eran generales y tenían dificultades para brindar críticas profundas.

Zhou cree que esto no excluye necesariamente el uso de tales herramientas en determinadas situaciones. Un ejemplo que citó son los investigadores que inician su carrera y que trabajan en el primer borrador de un trabajo de investigación. Pueden cargar un borrador en un programa LLM dedicado y recibir comentarios sobre deficiencias o errores en su borrador. Pero dada la naturaleza tediosa y algo repetitiva de la revisión por pares, algunos académicos temen que haya una tendencia a depender del resultado de un sistema de inteligencia artificial generativo capaz de proporcionar informes. “No hay gloria ni financiación asociada con la revisión por pares”, dice Elizabeth Judd, jefa de cultura y evaluación de la investigación en la Universidad de Loughborough en el Reino Unido. “Simplemente se considera un deber científico”. Ya existe evidencia de que los revisores pares Utilice ChatGPT y otros chatbots hasta cierto puntoA pesar de las reglas marcadas por algunos editores de revistas.

Thelwall cree que la IA puede hacer más para ayudar a los revisores pares a evaluar la calidad de la investigación, pero hay una razón por la que avanza con lentitud. “Sólo necesitamos muchas pruebas”, afirma, “y no sólo pruebas técnicas, sino también pruebas prácticas, en las que tengamos la confianza de que, si presentamos la IA a los revisores, por ejemplo, no la harán mal uso”.

Yadav considera que la IA ahorra tiempo y ha trabajado con ella para ayudar a evaluar rápidamente imágenes de vida silvestre tomadas con cámaras de campo en la India, pero la revisión por pares es demasiado importante para la comunidad científica como para dejarla en manos de robots. “Personalmente, me opongo completamente a que la IA sea revisada por pares”, afirma.

Proporcionando calidad

Uno de los beneficios más discutidos del uso de la IA es la idea de que puede ahorrar tiempo. Esto es particularmente evidente en los sistemas institucionales y nacionales de evaluación de la investigación, algunos de los cuales han incorporado inteligencia artificial. Por ejemplo, un financiador en Australia, el Consejo Nacional de Investigación Médica y de Salud (NHMRC), ya está utilizando IA a través de un “modelo híbrido que combina técnicas de aprendizaje automático y optimización matemática” para identificar revisores pares apropiados para juzgar las propuestas de subvención. El sistema ayuda a eliminar uno de los cuellos de botella administrativos en el proceso de evaluación, pero ahí es donde termina el uso de la IA. Un portavoz del Consejo Nacional de Investigación Médica y de Salud dice que la agencia “no utiliza inteligencia artificial, de ninguna manera, para ayudar directamente a evaluar la calidad de la investigación” en sí.

Pero incluso el uso de la IA para dicho apoyo administrativo podría suponer un importante ahorro de recursos, especialmente para evaluaciones nacionales de gran envergadura como el Marco de Evaluación de la Investigación. Se sabe que este ejercicio requiere mucho tiempo para los investigadores, dice Thelwall. Más de 1.000 académicos ayudan a evaluar la calidad de la investigación como parte de la evaluación de la investigación, y les lleva alrededor de medio año completarla.

“Si podemos automatizar las evaluaciones, supondremos un enorme aumento de la productividad”, afirma Thelwall. Existe un potencial de ahorro enorme: se estimó que la evaluación más reciente realizada en 2021 costó £471 millones (USD 618 millones).

Asimismo, Tim Fowler, director ejecutivo de la Comisión de Educación Superior del gobierno, describió la evaluación de los investigadores de Nueva Zelanda, o el Fondo de Investigación Basado en el Rendimiento, como un ejercicio “concienzudo”. En este ejercicio, los académicos someten sus expedientes a evaluación, lo que les impone una pesada carga a ellos y a las instituciones. En abril, el gobierno abolió este fondo y se encargó a un grupo de trabajo presentar un nuevo plan para febrero de 2025.

Estos ejemplos señalan el gran potencial de la IA para crear una mayor eficiencia, al menos para los grandes sistemas y procesos de evaluación burocráticos. Al mismo tiempo, la tecnología evoluciona a medida que las opiniones sobre lo que constituye la calidad de la investigación evolucionan y se vuelven más precisas. “La forma en que se definía la calidad de la investigación a principios del siglo XX no es como se define ahora”, dice Marnie Hughes-Warrington, vicepresidenta adjunta de investigación y empresa de la Universidad de Australia del Sur en Adelaida. Hughes-Warrington es miembro del Grupo de Transición de Excelencia en Investigación de Australia, que está examinando el futuro del ejercicio de evaluación del país después de que una revisión realizada en 2021 descubriera que suponía una carga demasiado grande para las universidades. Ella dice que la comunidad investigadora reconoce cada vez más la necesidad de mejorar la calidad de la investigación. Evaluar más “resultados de investigación no tradicionales” -como documentos políticos, obras creativas y exposiciones- y más allá de eso, hasta los impactos sociales y económicos.

A medida que las conversaciones se llevan a cabo junto con el auge de la IA, tiene sentido que las nuevas herramientas encajen en enfoques refinados para evaluar la calidad de la investigación. Por ejemplo, Hughes-Warrington señala cómo la IA ya se está utilizando para detectar manipulación de fotografías en revistas o para recopilar datos de sistemas utilizados para identificar de forma única a investigadores y documentos. La aplicación de este tipo de métodos sería coherente con la misión de instituciones como universidades y organismos nacionales. “¿Por qué las organizaciones, impulsadas por la curiosidad y la investigación, no implementan nuevas formas de hacer las cosas?”, pregunta.

Sin embargo, Hughes-Warrington también destaca áreas donde la integración de la IA puede encontrar resistencia. Hay preocupaciones sobre la privacidad, los derechos de autor y la seguridad de los datos que deben reconocerse, sesgos inherentes a las herramientas que deben superarse y la necesidad de considerar el contexto en el que se llevan a cabo las evaluaciones de las investigaciones, por ejemplo, cómo varían los efectos entre disciplinas, instituciones y países.

Gadd no se opone a la incorporación de la IA y dice que la ha visto surgir con más frecuencia en los debates sobre la calidad de la investigación. Pero advierte que los investigadores son ya una de las profesiones más valoradas del mundo. “Mi opinión general sobre esto es que estamos evaluando mucho”, dijo. “¿Estamos buscando utilizar la IA para resolver un problema que nosotros mismos hemos creado?”.

Después de haber visto cómo se realizan las evaluaciones basadas en bibliometría Podría perjudicar al sectorDado que métricas como los factores de impacto de las revistas se utilizan indebidamente como indicadores de la calidad y se demuestra que frenan la diversidad y los investigadores que inician su carrera, a Gad le preocupa cómo se implementará la IA, especialmente si los modelos se entrenan con estas mismas métricas. Las decisiones sobre la asignación de ascensos, financiación u otras recompensas siempre necesitarán una participación mucho más humana, afirma. “Hay que tener mucho cuidado”, dice, a la hora de recurrir a la tecnología “para tomar decisiones que afectarán la vida de las personas”.

Jade ha trabajado extensamente en el desarrollo de SCOPE, un marco para evaluar la investigación responsable de la Red Internacional de Sociedades de Gestión de la Investigación, una organización global que reúne a las sociedades de gestión de la investigación para coordinar actividades y compartir conocimientos en este campo. Uno de los principios clave del plan es “evaluar sólo cuando sea necesario”, afirma, y en esto puede haber una lección sobre cómo pensar en la integración de la IA. “Si evaluamos menos, podemos hacerlo con un estándar más alto”, afirma. “Quizás” la IA pueda respaldar este proceso, pero “muchos de los argumentos y preocupaciones que teníamos sobre la IA, los teníamos sobre la bibliometría”.

[ad_2]

Source Article Link