[ad_1]

Meta presentará la primera generación de su acelerador de inferencia de IA diseñado para impulsar los modelos de calificación y recomendación que son componentes centrales de Facebook e Instagram en 2023.

El chip Training and Inference Acceleration (MTIA), que puede manejar la inferencia pero no el entrenamiento, Actualizado en abrilSe duplicó el ancho de banda de computación y memoria de la primera solución.

En el reciente Simposio Hot Chips el mes pasado, Meta hizo una presentación sobre MTIA de próxima generación y admitió que el uso de GPU para motores de recomendación no está exento de desafíos. El gigante de las redes sociales señaló que el máximo rendimiento no siempre se traduce en un rendimiento eficiente, las grandes implementaciones pueden consumir muchos recursos y las limitaciones de capacidad se ven exacerbadas por la creciente demanda de IA generativa.

Ampliando la memoria ambigua

Teniendo esto en cuenta, los objetivos de desarrollo de Meta para la próxima generación de MTIA incluyen mejorar el rendimiento por TCO y por vatio en comparación con la generación anterior, manejar de manera eficiente los modelos en múltiples servicios Meta y mejorar la eficiencia de los desarrolladores para lograr rápidamente implementaciones de gran volumen.

La última versión de MTIA de Meta ha obtenido un importante aumento de rendimiento con GEN-O-GEN, aumentando los GEMM TOP en 3,5 veces a 177 TFLOPS en BF16, cuantificación de tensor basada en hardware para lograr una precisión similar a FP32 y soporte mejorado para el modo PyTorch Eager. , habilitando Permite tiempos de ejecución de trabajos de menos de 1 microsegundo y reemplazo de trabajos en menos de 0,5 microsegundos. Además, la optimización de TBE mejora los tiempos de descarga y carga de los subprocesos integrados, logrando tiempos de arranque entre 2 y 3 veces más rápidos en comparación con la generación anterior.

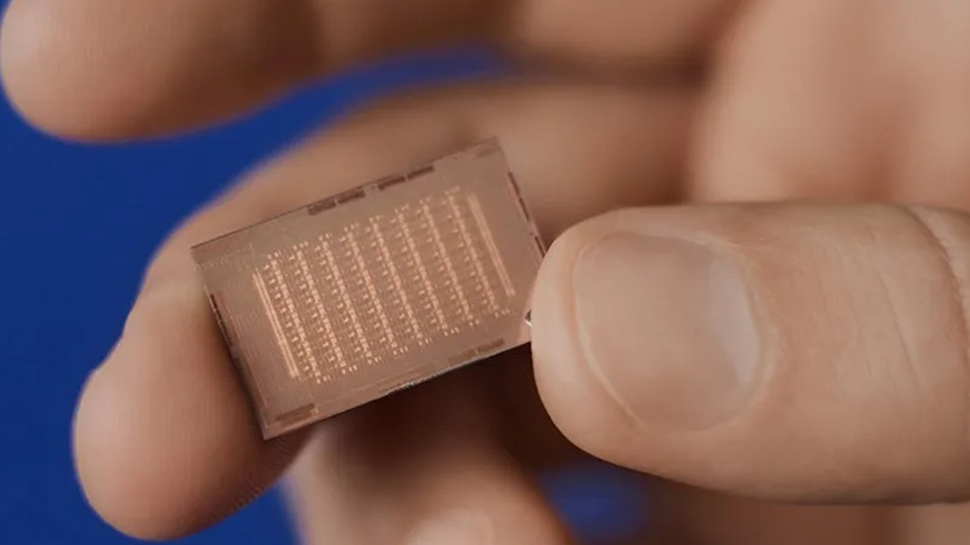

El chip MTIA, construido sobre el proceso de 5 nm de TSMC, funciona a 1,35 GHz con 2,35 mil millones de puertas y ofrece un rendimiento GEMM de 354 TOPS (INT8) y 177 TOPS (FP16), utilizando 128 GB de memoria LPDDR5 con 204,8 GB de ancho de banda/seg, todo. dentro de un TDP de 90W.

Los elementos de procesamiento se basan en núcleos RISC-V, con extensiones estándar y vectoriales, y el metaacelerador incluye CPU duales. En patatas fritas calientes 2024, Servicio a domicilio Noté una expansión de la memoria asociada con el adaptador PCIe y las CPU. Cuando se le preguntó si esto es CXL, Meta dijo tímidamente: “Es una opción para agregar memoria en el chasis, pero no está implementada actualmente”.

Más de TechRadar Pro

[ad_2]

Source Article Link