[ad_1]

Uno de los mayores obstáculos para enseñar nuevas habilidades a los robots es cómo transformar datos complejos y de alta dimensión, como imágenes de cámaras RGB integradas, en acciones que logren objetivos específicos. Los enfoques existentes normalmente se basan en representaciones 3D que requieren información de profundidad detallada o utilizan predictores jerárquicos que funcionan con planificadores de movimiento o políticas discretas.

Investigadores del Imperial College de Londres y Dyson El Robotics Learning Lab ha descubierto un nuevo enfoque que puede abordar este problema. El método de I+D tiene como objetivo cerrar la brecha entre las observaciones de alta dimensión y las acciones robóticas de bajo nivel, especialmente cuando los datos son escasos.

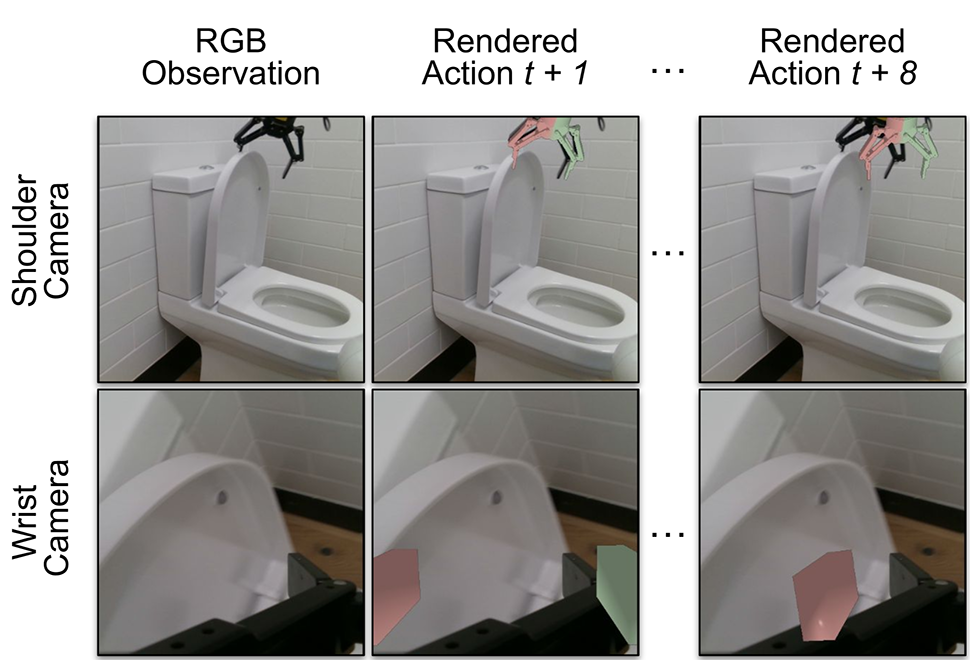

Investigación y desarrollo, detallados en un artículo publicado en servidor de preimpresión arXiv, aborda el problema mediante el uso de vistas virtuales de un modelo 3D del robot. Al representar acciones de bajo nivel dentro del espacio de observación, los investigadores pudieron simplificar el proceso de aprendizaje.

Imagina sus acciones dentro de la imagen.

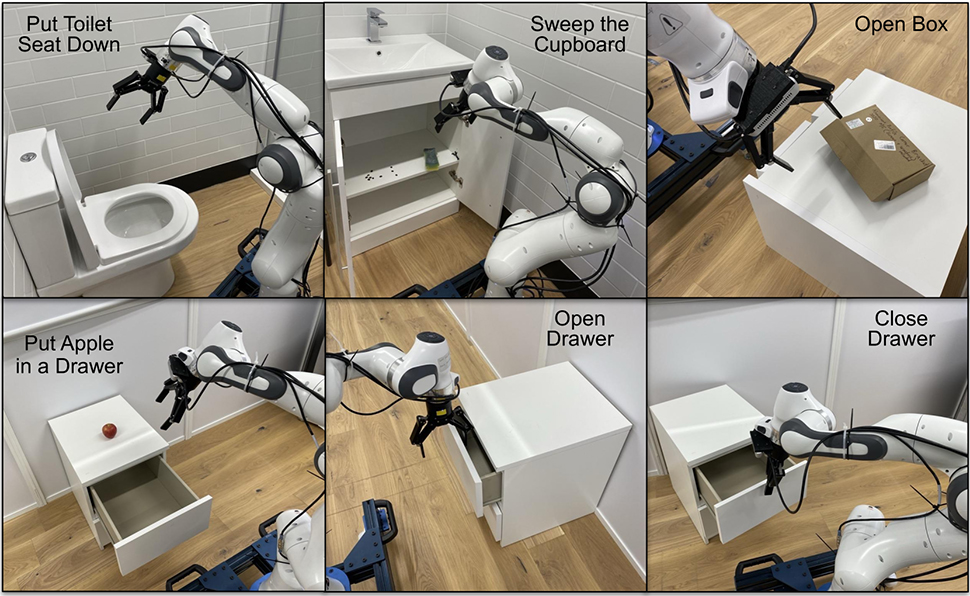

Un concepto al que los investigadores han aplicado esta tecnología es hacer que los robots hagan algo que a los hombres les resulta imposible, al menos según las mujeres, que es colocar el asiento del inodoro. El desafío consiste en realizar una observación de alta dimensión (ver el asiento del inodoro levantado) y combinarla con un movimiento robótico de bajo nivel (bajar el asiento).

Explorar tecnología “A diferencia de la mayoría de los sistemas robóticos, mientras aprenden nuevas habilidades manuales, los humanos no realizan cálculos extensos para determinar cuánto mover sus extremidades, sino que generalmente intentan imaginar cómo deben moverse sus manos para realizar una tarea determinada”.

Vitalis Vosselius, doctorado de último año. “Nuestro método, Render and Diffuse, permite a los robots hacer algo similar: 'visualizar' sus acciones dentro de una imagen utilizando representaciones virtuales de su propio avatar”, dijo un estudiante del Imperial College de Londres y autor principal del artículo “Representing the robot's”. Los movimientos y la retroalimentación juntos como imágenes RGB nos permiten enseñar a los robots a realizar diferentes tareas con menos demostraciones y a hacerlo a través de capacidades mejoradas de generalización espacial.

Un componente clave de la I+D es el proceso de difusión de lo aprendido. Esto mejora iterativamente las pantallas virtuales, actualizando la configuración del robot para que las acciones estén estrechamente alineadas con los datos de entrenamiento.

Los investigadores llevaron a cabo evaluaciones exhaustivas, probando varias variantes de I+D en entornos simulados y en seis tareas del mundo real, entre ellas levantar la tapa de una olla, colocar un teléfono en una base de carga, abrir una caja y mover un bloque hacia un objetivo. Los resultados fueron prometedores y, a medida que avance la investigación, este enfoque podría convertirse en la piedra angular del desarrollo de robots más inteligentes y adaptables para las tareas cotidianas.

“La capacidad de representar las acciones de los robots en imágenes abre posibilidades interesantes para futuras investigaciones”, dijo Fusselius. “Estoy particularmente entusiasmado con la combinación de este enfoque con potentes modelos basados en imágenes entrenados en grandes datos de Internet. Esto podría permitir que los robots se beneficien del conocimiento general que estos modelos capturan y al mismo tiempo puedan razonar sobre las acciones de los robots de bajo nivel”.

Más de TechRadar Pro

[ad_2]

Source Article Link