[ad_1]

- Los selfies deepfake ahora pueden eludir los sistemas de verificación tradicionales

- Los estafadores explotan la inteligencia artificial para crear una identidad sintética

- Las organizaciones deben adoptar métodos avanzados de detección basados en el comportamiento

Último informe mundial sobre fraude de identidad AU10TIX Revela una nueva ola en Fraude de identidadimpulsado en gran medida por ataques basados en inteligencia artificial.

Al analizar millones de transacciones entre julio y septiembre de 2024, el informe revela cómo las plataformas digitales en todos los sectores, especialmente las redes sociales, los pagos y las criptomonedas, enfrentan desafíos sin precedentes.

Los métodos de fraude han evolucionado desde simples falsificaciones de documentos hasta complejas identidades sintéticas, falsificaciones profundas y robots automatizados que pueden eludir los sistemas de verificación tradicionales.

Las plataformas de redes sociales han experimentado una escalada significativa en los ataques de bots automatizados en el período previo a las elecciones presidenciales de EE. UU. de 2024. El informe revela que los ataques a las redes sociales representaron el 28% de todos los intentos de fraude en el tercer trimestre de 2024, un salto notable con respecto a. sólo el 3% en el primer trimestre.

Estos ataques se centran en la desinformación y la manipulación de la opinión pública a gran escala. AU10TIX dice que las campañas de desinformación basadas en bots utilizan elementos avanzados de inteligencia artificial generativa (GenAI) para evadir la detección, una innovación que ha permitido a los atacantes escalar sus operaciones mientras evaden los sistemas de verificación tradicionales.

Los ataques impulsados por GenAI comenzaron a intensificarse en marzo de 2024 y alcanzaron su punto máximo en septiembre, y se cree que influyen en la percepción pública al difundir narrativas falsas y contenido incendiario.

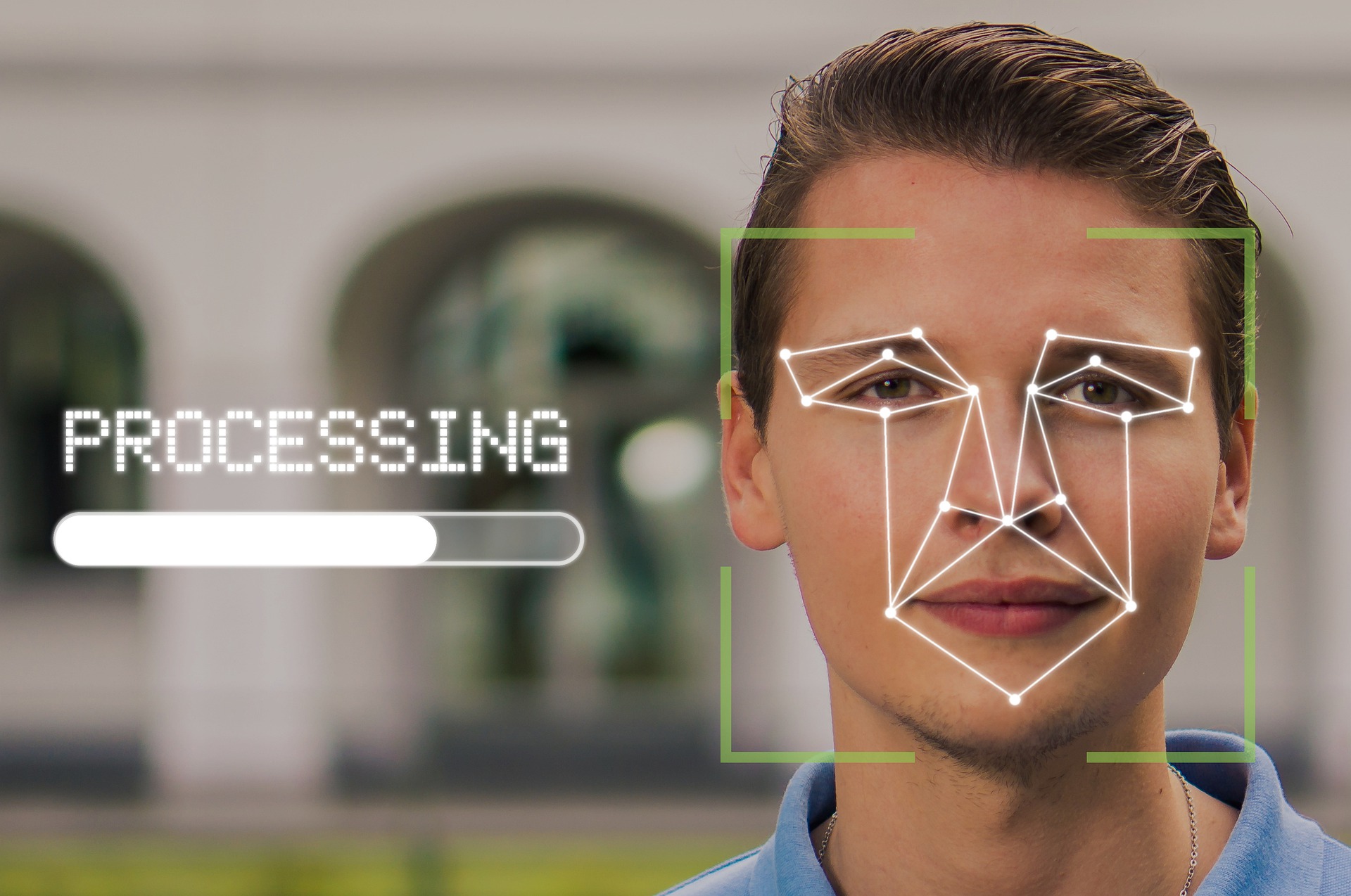

Entre los hallazgos más sorprendentes del informe se encuentra la aparición de selfies 100% falsos, que son imágenes hiperrealistas creadas para imitar rasgos faciales auténticos con el fin de eludir los sistemas de verificación.

Tradicionalmente, los selfies se han considerado un medio fiable de biometría. AutenticaciónPorque la tecnología necesaria para falsificar de manera convincente una imagen facial estaba fuera del alcance de la mayoría de los estafadores.

AU10TIX destaca que estos selfies sintéticos plantean un desafío único a los procedimientos tradicionales KYC (Conozca a su cliente). Este cambio sugiere que las organizaciones que dependen únicamente de la tecnología de comparación de rostros pueden necesitar reevaluar y mejorar sus métodos de detección.

Además, los estafadores utilizan cada vez más la IA para crear diversas formas de identidades sintéticas con la ayuda de ataques de “plantillas de imágenes”. Esto implica manipular una única plantilla de identificación para crear múltiples identidades únicas, completas con elementos fotográficos aleatorios, números de documentos y otros identificadores personales, lo que permite a los atacantes crear rápidamente cuentas fraudulentas en todas las plataformas aprovechando la IA para escalar la creación de identidades sintéticas.

En el sector de pagos, la tasa de fraude disminuyó en el tercer trimestre del 52% en el segundo trimestre al 39%. AU10TIX atribuye este progreso a una mayor supervisión regulatoria y a las intervenciones de aplicación de la ley. Sin embargo, a pesar de la disminución de los ataques directos, la industria de pagos sigue siendo el sector más atacado, y muchos estafadores, disuadidos por estrictas medidas de seguridad, redirigen sus esfuerzos hacia el mercado de las criptomonedas, que representa el 31% de todos los ataques en el tercer trimestre. .

AU10TIX recomienda que las organizaciones vayan más allá de los métodos tradicionales de verificación basados en documentos. Una recomendación fundamental es adoptar sistemas de detección basados en el comportamiento que vayan más allá de los controles de identidad estándar. Al analizar patrones en el comportamiento de los usuarios, como procedimientos de inicio de sesión, fuentes de tráfico y otras señales de comportamiento únicas, las empresas pueden identificar anomalías que indican una posible actividad fraudulenta.

“Los estafadores están evolucionando más rápido que nunca y aprovechando la IA para escalar y ejecutar sus ataques, especialmente en los sectores de medios sociales y pagos”, dijo Dan Yerushalmi, director ejecutivo de AU10TIX.

“Mientras las empresas utilizan la IA para mejorar la seguridad, los delincuentes utilizan la misma tecnología como arma para crear selfies sintéticos y documentos falsos, lo que hace que la detección sea casi imposible”.

También te puede gustar

[ad_2]

Source Article Link