[ad_1]

Antes del Día Mundial de la Accesibilidad el 16 de mayo de 2024, manzana Ha presentado una serie de nuevas funciones de accesibilidad para iPhone, iPad, Mac y Vision Pro. El seguimiento ocular encabeza una larga lista de nuevas funciones que te permitirán controlar tu iPhone y iPad moviendo los ojos.

El seguimiento ocular, la música háptica, los atajos de voz y las señales de tráfico de vehículos llegarán a los dispositivos Apple elegibles a finales de este año. Es probable que estas nuevas funciones de accesibilidad se lancen con iOS 18, iPadOS 18, VisionOS 2 y la próxima versión de macOS.

Estas nuevas funciones de accesibilidad se han convertido en un declive anual para Apple. El telón suele levantarse unas semanas antes WWDCtambién conocida como Conferencia Mundial de Desarrolladores, que comienza el 10 de junio de 2024. Este debería ser el evento en el que veamos a Apple mostrar su próxima generación de dispositivos insignia. Sistemas operativos Y chips de inteligencia artificial.

El seguimiento ocular parece realmente impresionante

El seguimiento ocular parece muy impresionante y es una forma esencial de hacer que su iPhone y iPad sean más accesibles. Como se menciona en el comunicado y se captura en un video, puedes navegar por iPadOS, así como por iOS, abrir aplicaciones e incluso controlar elementos, todo con solo tus ojos, y utiliza la cámara frontal, la inteligencia artificial y el aprendizaje automático nativo en todo momento. la experiencia.

Puede recorrer la interfaz y utilizar el “Control de permanencia” para manipular un botón o elemento. Los gestos también se manejarán únicamente mediante el movimiento de los ojos. Esto significa que primero puedes echar un vistazo a SafariO teléfono o cualquier otra aplicación, solo sigue haciendo clic en esta oferta y se abrirá.

Lo más importante es que todos los datos de configuración y uso se guardan localmente en el dispositivo, por lo que solo configurarás usando tu iPhone. No necesitarás ningún accesorio para utilizar el seguimiento ocular. Está diseñado para personas con discapacidades físicas y se basa en otras formas accesibles de controlar su iPhone o iPad.

Atajos de audio, acentos musicales y subtítulos en vivo en Vision Pro

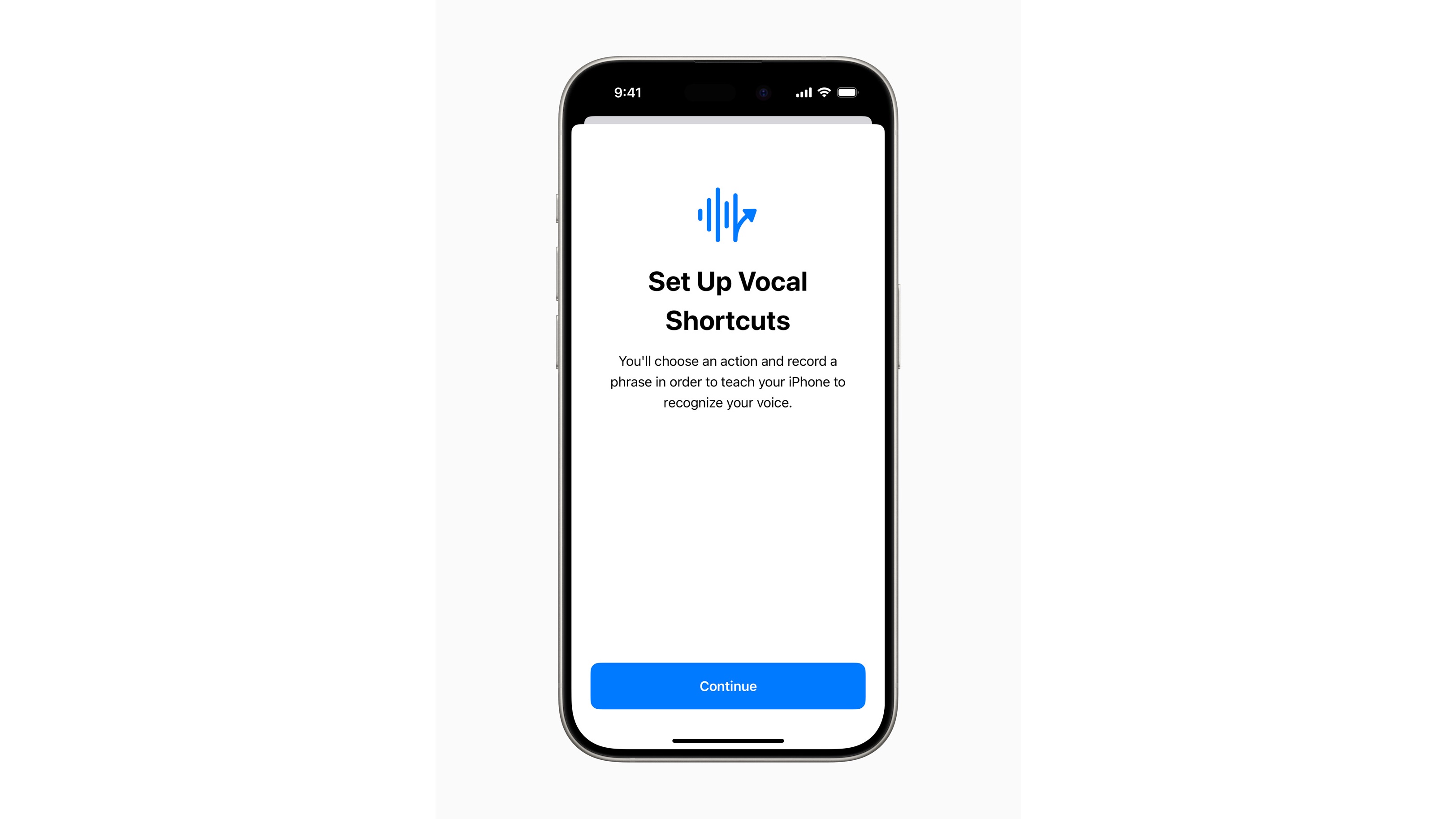

Otra nueva característica de accesibilidad son los atajos vocales, diseñados para usuarios de iPad y iPhone con esclerosis lateral amiotrófica (ELA), parálisis cerebral, accidente cerebrovascular o “condiciones adquiridas o progresivas que afectan el habla”. Esto te permitirá configurar una voz personalizada que Siri puede aprender y reconocer para activar un atajo específico o realizar una tarea. Convive con Atípico Speech Listening, diseñado para los mismos usuarios, para abrir el reconocimiento de voz a un grupo más amplio.

Ambas funciones se basan en algunas de las funciones introducidas en iOS 17, por lo que es genial ver que Apple continúa innovando. Específicamente con el habla atípica, Apple usa IA para aprender y reconocer diferentes tipos de habla.

Music Haptics en iPhone está diseñado para usuarios con problemas de audición o sordos para experimentar la música. El Click Engine incorporado, que potencia la háptica del iPhone, activará diferentes vibraciones, como clics y texturas, que se asemejan al sonido de una canción. En el lanzamiento, funcionará con “millones de canciones” dentro de Apple Music, y habrá una API abierta para que los desarrolladores implementen y pongan a disposición música de otras fuentes.

Además, Apple tiene vistas previas de algunas otras funciones y actualizaciones. Las señales de movimiento del vehículo estarán disponibles en iPhone y iPad y tendrán como objetivo reducir el mareo con puntos móviles en esa pantalla que cambian cuando se detecta movimiento del vehículo. Está diseñado para ayudar a reducir el mareo sin bloquear todo lo que estás viendo en la pantalla.

Una de las principales incorporaciones que llegará a VisionOS, también conocido como el software que impulsa Apple Vision Pro, serán los subtítulos en vivo en todo el sistema. Esto permitirá que los subtítulos de los diálogos hablados dentro de las conversaciones de FaceTime y el audio de las aplicaciones se vean frente a usted. La versión de Apple señala que está diseñada para usuarios sordos o con problemas de audición, pero como todas las funciones de accesibilidad, se puede encontrar en Configuración.

Dado que se trata de subtítulos en vivo en Apple Vision Pro, puede mover la ventana que contiene los subtítulos y ajustar el tamaño como cualquier otra ventana. La accesibilidad dentro de VisosOS también obtendrá una menor transparencia, inversión inteligente y funcionalidad de luz parpadeante tenue.

En cuanto a cuándo se enviarán estos dispositivos, Apple señala en el comunicado que “nuevas funciones de accesibilidad [are] “Llegará a finales de este año”. Lo seguiremos de cerca e imaginaremos que estas funciones vendrán con sistemas operativos de próxima generación como iOS 18 y iPadOS 18, lo que significa que las personas con una cuenta de desarrollador podrán probar estas funciones en próximas betas.

Dado que algunas de estas funciones funcionan con inteligencia artificial y aprendizaje automático en el dispositivo, ayudar con las funciones de accesibilidad es una forma en que Apple cree que la IA tiene el potencial de generar un impacto. Es probable que escuchemos al gigante tecnológico compartir más opiniones sobre la IA y sus funciones listas para el consumidor. Conferencia mundial de desarrolladores 2024.

También te puede interesar

[ad_2]

Source Article Link