[ad_1]

Si utiliza LinkedIn, es posible que se haya topado con usuarios que se quejan de que la plataforma está utilizando sus datos para entrenar una herramienta de inteligencia artificial generativa sin su consentimiento.

La gente comenzó a notar este cambio en la configuración el miércoles 18 de septiembre, cuando la plataforma de redes sociales propiedad de Microsoft entró en funcionamiento. Entrene la IA con datos previos al usuario Actualizar sus términos y condiciones.

Ciertamente, LinkedIn no es la primera plataforma de redes sociales que comienza a recopilar datos de los usuarios para alimentar una herramienta de inteligencia artificial sin pedir consentimiento informado. Lo curioso de la saga de IA de LinkedIn es la decisión de excluir a la Unión Europea, el Espacio Económico Europeo (Islandia, Liechtenstein y Noruega) y Suiza. ¿Es esto una señal de que sólo las leyes de privacidad similares a las de la UE pueden proteger completamente nuestra privacidad?

Reacción de la UE contra el entrenamiento en IA

Antes de LinkedIn, tanto Meta (la empresa matriz detrás de Facebook, Instagram y WhatsApp) como X (anteriormente conocida como Twitter) comenzaron a utilizar los datos de sus usuarios para entrenar sus modelos de IA lanzados recientemente. Si bien los dos gigantes de las redes sociales inicialmente ampliaron el plan para incluir también a países europeos, se vieron obligados a detener el entrenamiento en IA después de enfrentar la reacción de los reguladores de privacidad de la UE.

Empecemos en orden. Los primeros en probar las aguas fueron Facebook e Instagram en junio. Según sus nuevos datos, política de privacidad – que entró en vigor el 26 de junio de 2024 – la empresa ahora puede utilizar años de publicaciones personales, fotografías privadas o datos de seguimiento en línea para entrenar Metainteligencia artificial.

¿Sabías?

la semana pasada, muerto lo confieso ha estado utilizando publicaciones públicas de personas para entrenar modelos de IA desde 2007.

Después del grupo de defensa de los derechos digitales en Austria Noib presentó 11 quejas de privacidad En una carta dirigida a varias autoridades de protección de datos (APD) en Europa, la DPA irlandesa pidió a la empresa que detuviera sus planes de utilizar los datos de los usuarios de la UE y el EEE.

dijo muerto Meta AI expresó su decepción con la decisión, calificándola de “un paso atrás para la innovación europea” en IA, y decidió cancelar el lanzamiento de Meta AI en Europa, ya que no quería ofrecer una “experiencia de segunda categoría”.

Algo similar ocurrió a finales de julio cuando X habilitó Su entrenamiento de IA con Grok Sobre toda la información pública de sus usuarios –incluidas las cuentas europeas.

Unos días después del lanzamiento, el 5 de agosto, las organizaciones de consumidores comenzaron Presentar una queja formal de privacidad La Comisión Irlandesa de Protección de Datos (DPC) lamenta que la herramienta de inteligencia artificial de X viole las normas del RGPD. El tribunal irlandés emitió caído ahora Caso de privacidad contra X, ya que la plataforma acordó dejar de recopilar permanentemente datos personales de los usuarios de la UE para entrenar su modelo de inteligencia artificial.

Si bien las empresas de tecnología han criticado a menudo el fuerte enfoque regulatorio de la UE hacia la IA, incluso recientemente un grupo de organizaciones firmó un acuerdo. Carta abierta Los expertos en privacidad han acogido con satisfacción el enfoque proactivo al exigir una mayor certeza regulatoria en torno a la IA para fomentar la innovación.

El mensaje es contundente: Europa no está dispuesta a sacrificar su sólido marco de privacidad.

Por lo tanto, LinkedIn se ha unido a otras plataformas intermediarias depredadoras para apoderarse del contenido generado por los usuarios con el fin de entrenar la IA generativa de forma predeterminada, excepto en el territorio del RGPD. A nivel mundial, el RGPD y los reguladores europeos de protección de datos parecen ser el único antídoto eficaz en este caso. pic.twitter.com/8shCd5AWRU18 de septiembre de 2024

Aunque LinkedIn lo tiene ahora Actualizado Según los términos de servicio, esta medida silenciosa provocó intensas críticas sobre la privacidad y la transparencia fuera de Europa. TúDe hecho, las personas que deseen que su información y publicaciones no se utilicen para entrenar la nueva herramienta de IA deben optar activamente por no hacerlo.

Como se mencionó anteriormente, tanto X como Meta utilizaron tácticas similares al alimentar sus modelos de IA con información personal, fotos, videos y publicaciones públicas de los usuarios.

Sin embargo, según algunos expertos, el hecho de que otras empresas del sector actúen sin transparencia no significa que sea correcto que lo hagan.

“No deberíamos tener que tomar una serie de medidas para deshacer una elección que una empresa tomó en nombre de todos nosotros”. Rachel Toback tuiteó“, hacker ético y director ejecutivo de SocialProof Security. “Las organizaciones creen que pueden salirse con la suscripción automática porque 'todo el mundo lo hace'. “Si nos unimos y exigimos que las organizaciones nos permitan participar, es de esperar que las cosas cambien algún día”.

Cómo darse de baja de la formación en IA de LinkedIn

Como se muestra en LinkedIn Preguntas frecuentes (Que se actualizó hace una semana al momento de escribir este artículo): “Optar por no participar significa que LinkedIn y sus afiliados no utilizarán sus datos personales o contenido en LinkedIn para capacitar a modelos futuros, pero esto no afecta la capacitación que ya se ha realizado. “

En otras palabras, los datos ya recopilados no se pueden recuperar, pero aún puedes evitar que el gigante de las redes sociales utilice más contenido tuyo en el futuro.

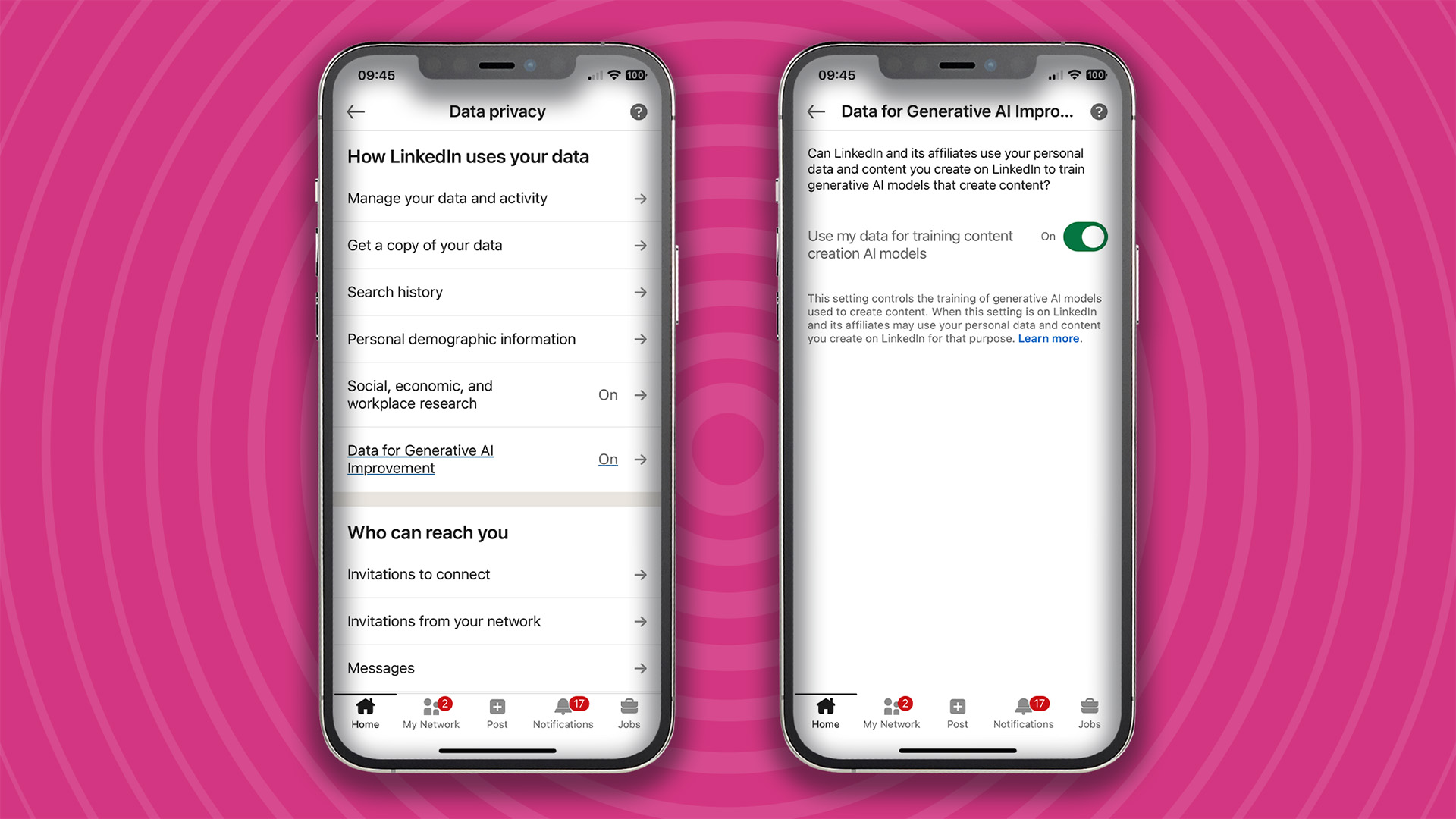

Hacerlo es sencillo. Todo lo que tienes que hacer es dirigirte a Ajustes menú y seleccione Privacidad de datos Como se muestra en la imagen a continuación, una vez que vaya allí, verá que Datos para mejorar la inteligencia artificial generativa La función está activada de forma predeterminada. En este punto, es necesario Haga clic en él y desactive el botón de alternancia. A la derecha

[ad_2]

Source Article Link