[ad_1]

no lo esperaba gafas de Google Para hacer un ligero regreso en Google I/O 2024Pero esto se hizo gracias al proyecto Astra.

este GoogleNombre de un nuevo prototipo de agentes de IA, impulsado por mellizo La IA multimodal, que puede comprender entradas de vídeo y voz, reaccionar de forma inteligente a lo que una persona mira activamente y responder consultas relacionadas.

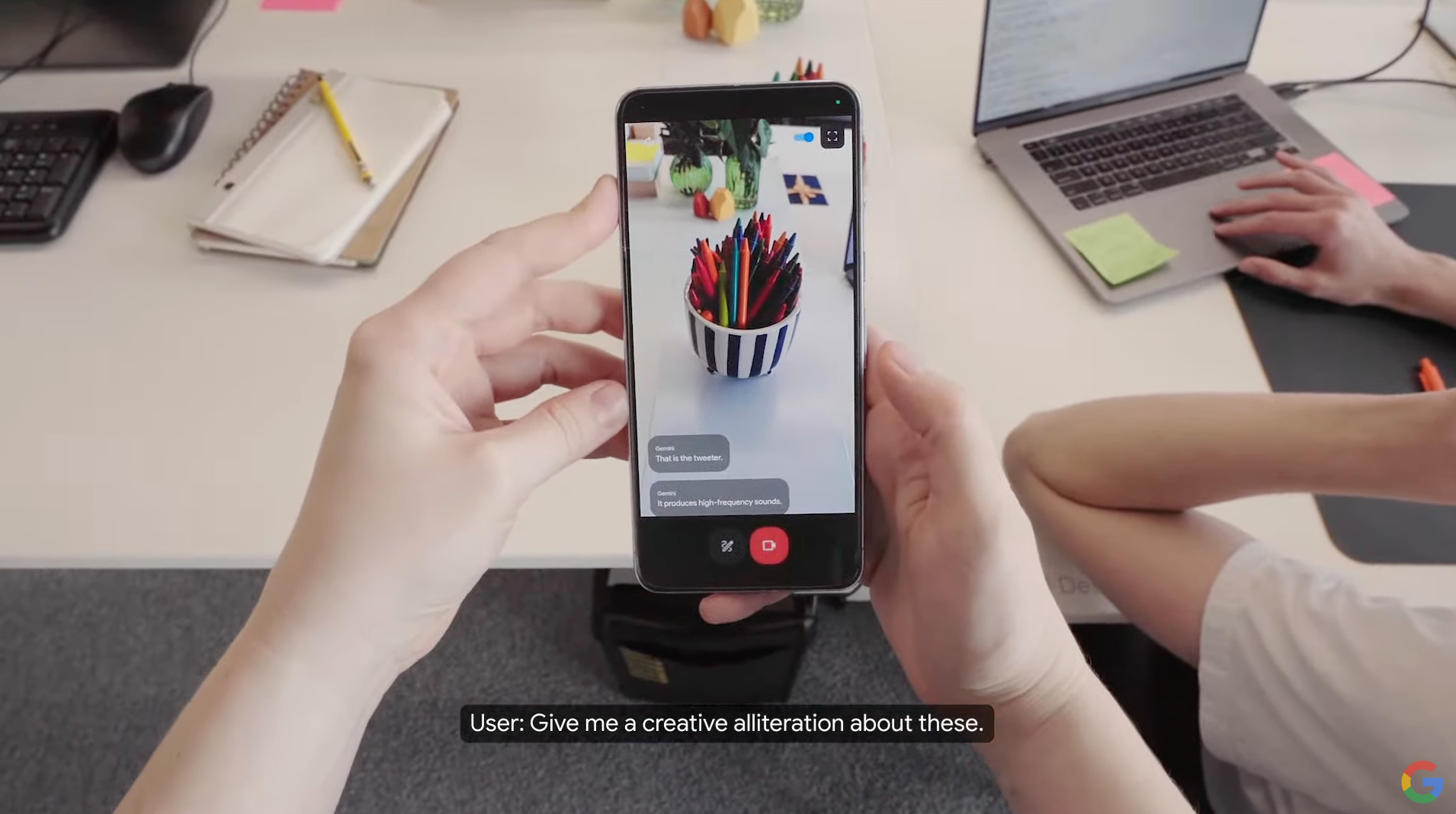

El Proyecto Astra se describe como una “IA universal” que puede ser “realmente útil en la vida cotidiana” y está diseñado para ser proactivo, enseñable y capaz de comprender el lenguaje natural. En un vídeo, Google demostró esto con alguien usando algo similar. Píxel 8 Pro Con Astra AI ejecutándose.

Al apuntar la cámara del teléfono a la habitación, la persona pudo pedirle a Astra que “me avise cuando vea algo haciendo un sonido”, y la IA etiquetó un altavoz que podía ver dentro de la lente de la cámara. A partir de ahí, la persona podía preguntar sobre una parte específica del altavoz, y la IA respondía que la parte en cuestión es un altavoz y trata con altas frecuencias.

Pero Astra hace mucho más que eso: puede identificar un código en la pantalla y explicar lo que está haciendo, y puede identificar dónde está alguien en la ciudad y proporcionar una descripción de esa área. Bueno, cuando se actualiza, también puede crear una oración que rima alrededor de un montón de lápices de colores, al estilo del Dr. Zeus.

Incluso puede recordar dónde dejó un usuario un par de gafas, y la IA recuerda dónde las vio por última vez. Pudo hacer esto último ya que la IA está diseñada para codificar cuadros de video de lo que ve, combinar ese video con entradas de voz y juntarlos en una línea de tiempo de eventos, y almacenar en caché esa información para poder recuperarla rápidamente más tarde. .

Luego, Astra se dirigió a una persona que llevaba “gafas inteligentes” Google Glass y pudo ver que la persona estaba mirando un diagrama de un sistema en una pizarra, y descubrió dónde se podían realizar mejoras cuando se le preguntó al respecto.

Habilidades como esta de repente hacen que Glass parezca realmente útil, en lugar del dispositivo ligeramente espeluznante y posiblemente inútil que era hace unos años; Quizás veamos a Google regresar al campo de las gafas inteligentes a continuación.

El Proyecto Astra puede hacer todo esto gracias al uso de IA multimodal, que en términos simples es una combinación de modelos de redes neuronales que pueden procesar datos y entradas de múltiples fuentes; Considere mezclar información de cámaras y micrófonos con conocimientos con los que la IA ya ha sido entrenada.

Google no ha dicho cuándo el Proyecto Astra se convertirá en producto, ni siquiera en manos de los desarrolladores, pero el director ejecutivo de DeepMind de Google, Demis Hassabis, dijo que “algunas de estas capacidades llegarán a los productos de Google, como la aplicación Gemini, a finales de este año”. Si esto no significa Google Píxel 9que esperamos llegue a finales de este año.

Ahora bien, vale la pena tener en cuenta que el Proyecto Astra se mostró en un vídeo muy interesante, y la realidad de tener estos agentes de IA a bordo es que pueden sufrir latencia. Pero es una mirada prometedora a cómo Google probablemente integrará herramientas de inteligencia artificial realmente útiles en sus productos futuros.

También te puede interesar

[ad_2]

Source Article Link