[ad_1]

Algunos investigadores creen que los sistemas de inteligencia artificial pronto alcanzarán el nivel de la inteligencia humana. Otros piensan que está muy lejos.Crédito: Getty

La empresa de tecnología OpenAI fue noticia el mes pasado cuando su último prototipo de chatbot, o3, logró una puntuación alta en una prueba que marcó el progreso hacia… Inteligencia artificial general (vengo). El o3 de OpenAI obtuvo una puntuación del 87,5%, superando la mejor puntuación anterior del sistema de inteligencia artificial (IA) del 55,5%.

¿Qué tan cerca está la inteligencia artificial de la inteligencia humana?

Se trata de “un verdadero avance”, afirma François Cholet, el investigador de IA que creó la prueba, denominada Grupo de Abstracción e Inferencia para la Inteligencia General Artificial (ARC-AGI).1en 2019 mientras trabajaba en Google, con sede en Mountain View, California. Obtener una puntuación alta en la prueba no significa que se haya logrado la inteligencia artificial general, ampliamente definida como un sistema informático que puede pensar, planificar y aprender habilidades como los humanos, sino que o3 es “absolutamente” capaz de pensar y razonar. , dice Schulet. “Tiene un poder de circulación muy grande”.

Los investigadores quedaron impresionados por el rendimiento de o3 a través de Una variedad de pruebas o estándares.incluida la prueba extremadamente desafiante FrontierMath, que fue anunciada en noviembre por el instituto de investigación virtual Epoch AI. “Es muy impresionante”, dice David Wren, investigador de medición de IA en el Grupo de Investigación de Amenazas y Evaluación de Modelos, con sede en Berkeley, California.

ChatGPT pasó la prueba de Turing y comienza la carrera para encontrar nuevas formas de evaluar la inteligencia artificial

Pero muchos, incluido Ren, advierten que es difícil saber si la prueba ARC-AGI realmente mide la capacidad de una IA para razonar y generalizar. “Hubo muchas medidas que pretendían medir algo básico para la inteligencia, pero resultó que no lo hacían”, dice Ren. Dice que continúa la búsqueda de mejores pruebas que nunca.

OpenAI, con sede en San Francisco, no reveló cómo funcionaría o3, pero el sistema llegó a escena poco después. Formulario de empresa O1que utiliza la lógica de la “cadena de pensamiento” para resolver problemas hablando consigo mismo a través de una serie de pasos de pensamiento. Algunos especialistas creen que o3 puede producir una serie de diferentes trenes de razonamiento para ayudar a delimitar la mejor respuesta entre un conjunto de opciones.

Dedicar más tiempo a refinar una respuesta en el momento del examen marca una gran diferencia en las puntuaciones, dice Chollet, que actualmente vive en Seattle, Washington. Pero o3 tiene un costo enorme: procesar cada tarea en la prueba ARC-AGI, su modo de puntuación alta toma un promedio de 14 minutos y probablemente cueste miles de dólares. (Los costos de computación se basan en cuánto cobra OpenAI a los clientes por símbolo o palabra, lo que depende de factores que incluyen el uso de electricidad y los costos de hardware, dice Chollet). Esto “genera preocupaciones sobre la sostenibilidad”, dice Xiang Yu de la Universidad Carnegie Mellon en Pittsburgh, Pensilvania, que estudia modelos de lenguaje grande (LLM) que impulsan los chatbots.

Generalmente inteligente

Aunque el término inteligencia artificial general (AGI) se utiliza a menudo para describir un sistema informático que cumple o supera las capacidades cognitivas humanas en una amplia gama de tareas, no existe una definición técnica para ello. Como resultado, no hay consenso sobre cuándo las herramientas de IA pueden lograr AGI. Algunos dicen que ya llegó el momento; Otros dicen que aún queda un largo camino por recorrer.

Se están desarrollando muchas pruebas para seguir el progreso hacia el AGI. Algunos de ellos, incluido el cuestionario de preguntas y respuestas a prueba de Google de 2023 de Rein2Tiene como objetivo evaluar el desempeño de un sistema de inteligencia artificial sobre problemas científicos a nivel de doctorado. El asiento MLE 2024 de OpenAI enfrenta a la IA con 75 desafíos alojados en Kaggle, una plataforma de competencia de ciencia de datos en línea. Los desafíos incluyen problemas del mundo real, como la traducción de manuscritos antiguos y el desarrollo de vacunas.3.

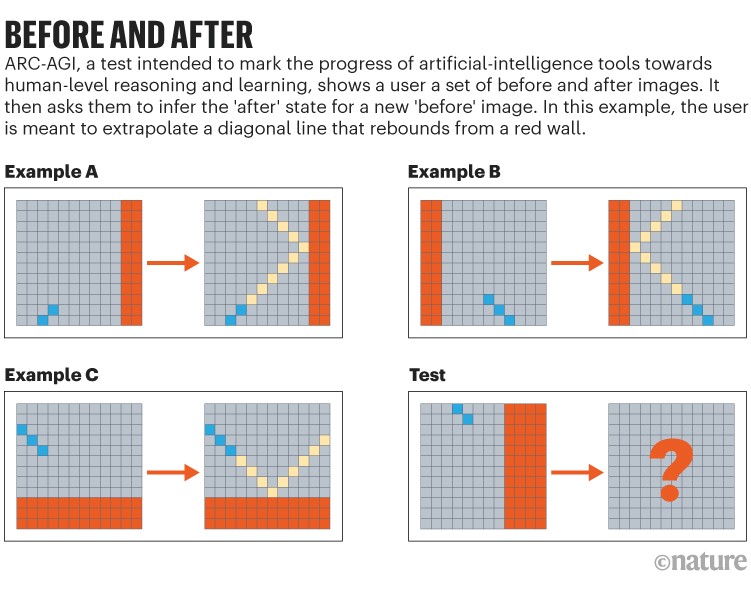

Fuente: Referencia. 1

Las buenas normas deben evitar una serie de problemas. Por ejemplo, es esencial que la IA no vea las mismas preguntas durante su entrenamiento, y las preguntas deben diseñarse de tal manera que la IA no pueda hacer trampa tomando atajos. “Los estudiantes de maestría son expertos en aprovechar señales textuales sutiles para extraer respuestas sin pensar realmente”, dice Yu. Añade que se supone que las pruebas serán tan caóticas y ruidosas como las condiciones del mundo real, y al mismo tiempo establecerán objetivos de eficiencia energética.

Yue dirigió el desarrollo de una prueba llamada Escala multidisciplinaria de comprensión y razonamiento integral para inteligencia artificial general experta (MMMU), que pide a los chatbots que realicen tareas visuales de nivel universitario, como interpretar notas musicales, gráficos y diagramas de circuitos.4. O1 de OpenAI tiene el récord actual de MMMU del 78,2% (se desconoce el puntaje de o3), en comparación con un desempeño humano de alto nivel del 88,6%, dice Yue.

Por el contrario, ARC-AGI se basa en matemáticas básicas y habilidades de reconocimiento de patrones que los humanos suelen desarrollar en la primera infancia. Proporciona a los examinados un conjunto ilustrativo de diseños de antes y después, y les pide que infieran el estado “después” de un nuevo diseño “antes” (consulte “Antes y después”). “Me gusta la prueba ARC-AGI por su perspectiva complementaria”, dice Yu.

[ad_2]

Source Article Link