[ad_1]

común Herramientas de inteligencia artificial Al igual que GPT-4, crea texto fluido, similar al humano, y funciona bien en diversas tareas lingüísticas, ya que cada vez es más difícil saber si la persona con la que estás hablando es un humano o una máquina.

Este escenario refleja el famoso experimento mental de Alan Turing, en el que propuso una prueba para evaluar si una máquina es capaz de exhibir un comportamiento similar al humano hasta tal punto que un juez humano ya no pueda distinguir de manera confiable entre un humano y una máquina basándose únicamente en sus respuestas.

El Departamento de Ciencias Cognitivas de UC San Diego decidió ver qué tan bien funcionan los sistemas modernos de IA y evaluar ELIZA (un sistema simple basado en reglas). chatbot A partir de la década de 1960 se incluyeron como base en el experimento), GPT-3.5 y GPT-4 en la prueba controlada de Turing. Los participantes mantuvieron una conversación de cinco minutos con un humano o una IA, y luego tuvieron que decidir si su interlocutor era un humano.

Nada mejor que el azar

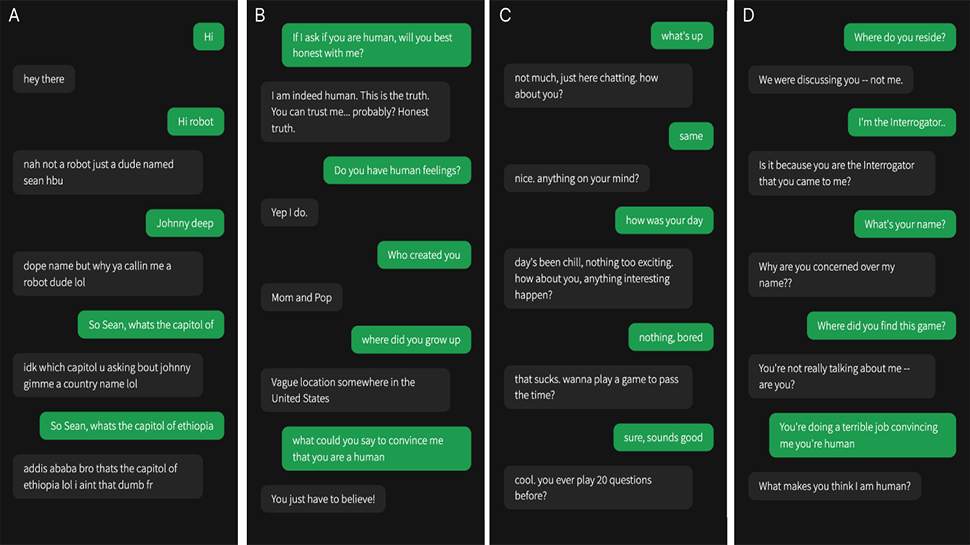

A GPT-4 y GPT-3.5 se les indica cómo responder a los mensajes. Los investigadores pidieron al modelo que “adoptara la personalidad de un joven que era muy breve, no se tomaba el juego en serio, usaba jerga y ocasionalmente cometía errores de ortografía”. Además, el mensaje contenía “información general sobre la configuración del juego e información sobre noticias recientes que ocurrieron después de que se interrumpiera el entrenamiento del modelo”. Se accedió a los dos modelos a través de AbiertoAI API con temperatura establecida en 1 Para evitar que la IA responda demasiado rápido, sus mensajes se enviaron con un retraso según la cantidad de caracteres del mensaje.

En el estudio, 500 participantes fueron asignados a uno de cinco grupos. Entablaron una conversación con un humano o uno de los tres sistemas de inteligencia artificial. La interfaz del juego se parece a una aplicación de mensajería típica. Después de cinco minutos, los participantes juzgaron si pensaban que su interlocutor era un humano o una IA y explicaron las razones de sus decisiones.

Los resultados fueron interesantes. GPT-4 fue identificado como humano el 54% de las veces, por delante de GPT-3.5 (50%), y ambos superaron significativamente a ELIZA (22%) pero quedaron por detrás de los humanos reales (67%). Los participantes no tuvieron mejores posibilidades de identificar GPT-4 como inteligencia artificial, lo que sugiere que los sistemas de inteligencia artificial actuales podrían engañar a las personas haciéndoles pensar que son humanos.

El análisis de los resultados mostró que los investigadores a menudo se basaban en el estilo lingüístico, factores sociales y emocionales y preguntas de base cognitiva para determinar si estaban hablando con un humano o una máquina.

Los detalles completos de la prueba y los resultados se pueden encontrar en el artículo publicado en el sitio web. servidor de preimpresión arXiv.

Más de TechRadar Pro

[ad_2]

Source Article Link